Google Search 啟用 Live 語音互動,讓虛擬主持人以對話方式說明搜尋結果。

Google 宣布在旗下 iOS 與 Android 版本的 Google App 中,正式推出名為「Search Live」的全新語音互動搜尋功能。

這項功能目前僅在美國開放使用,用戶需透過 Google Labs 中的 AI 模式開啟後才能使用,而在啟用之後,就能像與虛擬助理對話般,與搜尋引擎展開自然流暢的語音互動。

結合 Gemini 的 AI 語音模型,實現雙向語音對話體驗

Search Live 的最大特點,就是讓使用者可透過語音「與搜尋引擎對話」。只需打開 Google App 並點選畫面上的 Live 圖示,即可直接發問,Google 將以 AI 生成的語音方式回覆,並能立即進行追問,無需再點選或輸入指令。

在實際應用上,Google 以「如何防止亞麻洋裝在行李箱中變皺」為範例,使用者不但可以語音提問,還能連續詢問後續問題,如適合的收納方式或材質差異分析,整個互動過程無需退出畫面或重新觸發指令,甚至能在開啟其他 App 的情況下持續進行語音對話。

此項功能背後的技術核心,來自於 Google 為語音體驗量身打造的 Gemini 變體模型,強調自然語言理解與語音合成能力,讓整體互動更接近與真人助理的對話方式。

網頁內容可能淪為背景資料

雖然 Search Live 大幅提升語音搜尋的便利性與即時性,特別適合忙碌或需要騰出雙手的情境 (如打包行李、烹飪或步行中),但也引發一些關於網路流量與內容引用的疑慮。雖然系統會在畫面下方以小卡片形式顯示引用來源網頁,但若使用者完全透過語音完成互動,這些網頁很可能被忽視,導致實際內容創作者無法從中獲得流量回報。

這也是目前 AI 搜尋工具普遍面臨的倫理與商業挑戰之一。

未來還可「看圖說話」,即時畫面也能互動解答

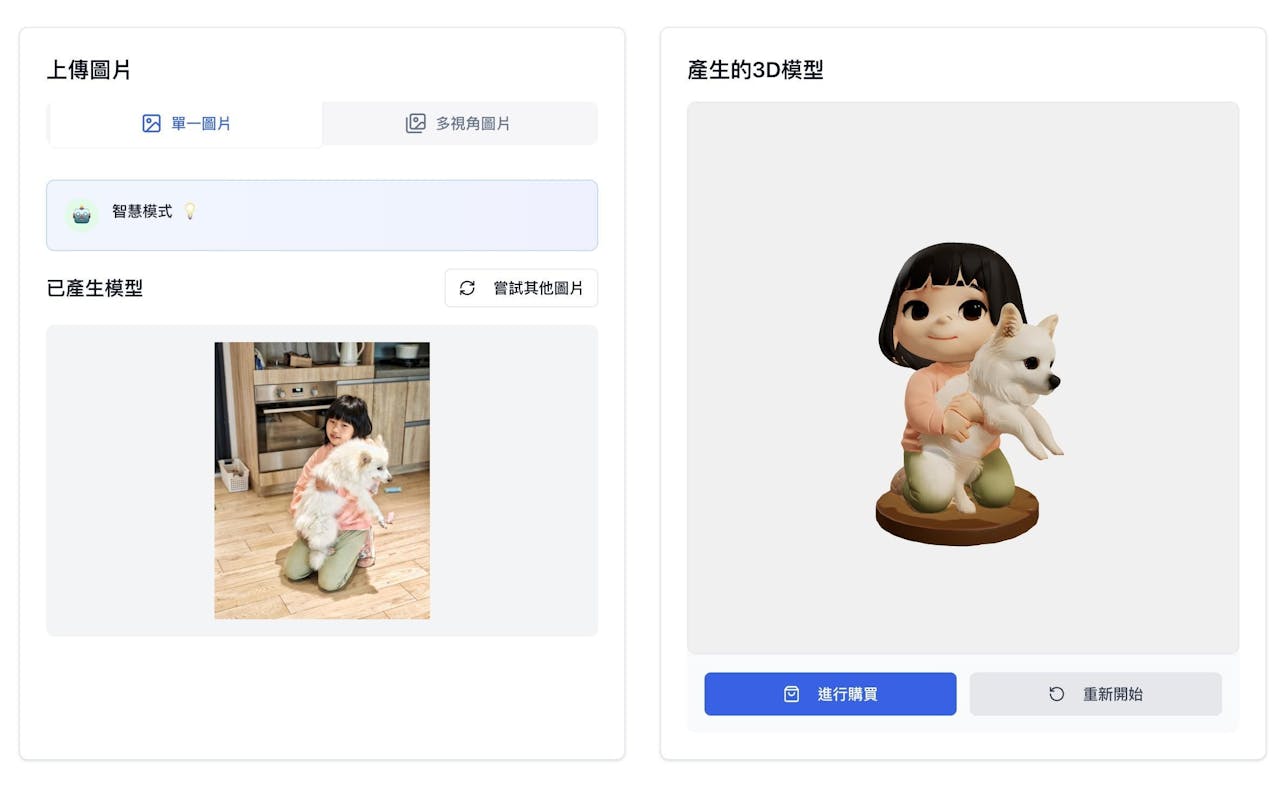

Google 也透露,接下來將擴展 Search Live 功能,加入「視覺互動」元素。未來,使用者將可直接用鏡頭對準物體、文字或問題畫面進行提問,例如對著一道數學題拍照並詢問解法,或請 AI 解釋難以理解的圖示或名詞。

這項視覺搜尋功能,其實已經在今年 Google I/O 開發者大會上預告,將進一步結合多模態 AI 實現「看見什麼,就能問什麼」的即時解答能力。

Search Live 不只是語音搜尋的進化版,更像是為手機打造的 AI 助理平台。結合 Gemini 技術後,Google 明顯希望讓搜尋成為更具互動感、個人化與多元形式的資訊查詢入口。不過,如何平衡使用便利性與內容提供者的權益,仍是未來此類 AI 搜尋工具不可忽視的課題。