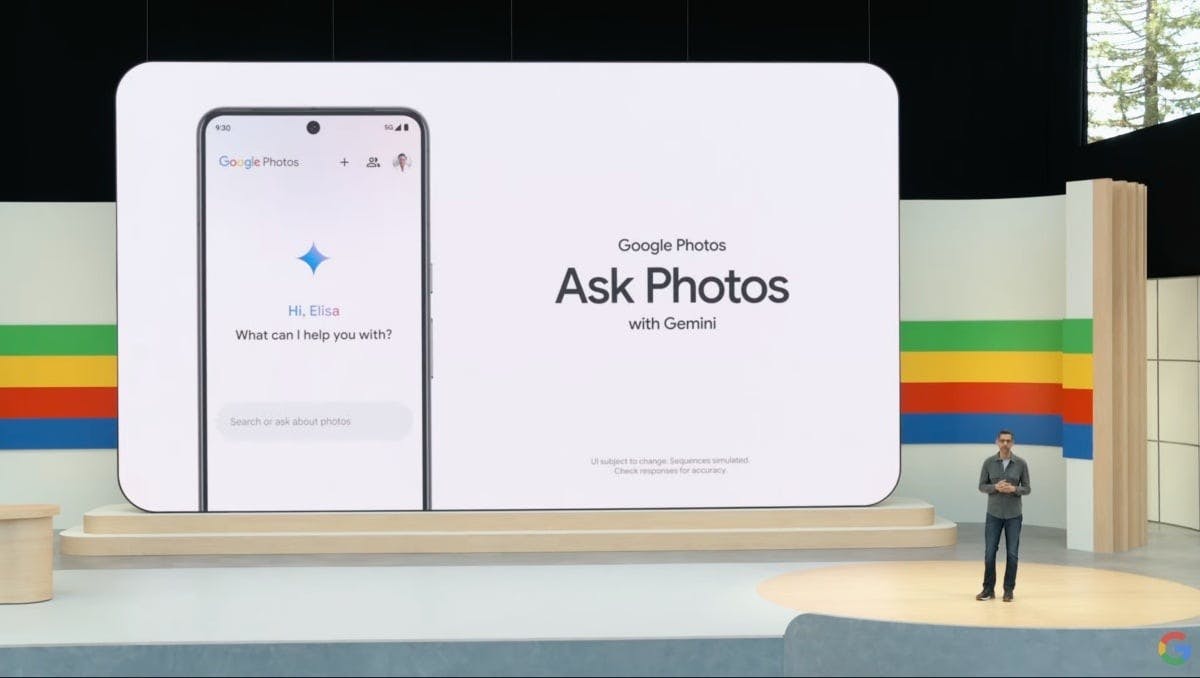

Google 在美國重啟 Ask Photos AI 圖片搜尋功能,能更快速解析與搜尋相片內容。

曾在Google I/O 2024公布、讓使用者能以自然語言搜尋Google Photos照片內容的Ask Photos功能,在日前經過暫停推出的調整後,Google稍早宣布重新在美國地區開放使用此功能,並且針對反應較慢與介面設計進行調整,強調能更快提供搜尋結果,同時保留Gemini AI模型帶來的智慧理解能力。

結合傳統搜尋與AI回應,加快使用體驗

根據Google說法,此次調整最大重點在於「速度」。原先Ask Photos完全依賴Gemini AI模型處理所有搜尋指令,但這樣的架構在簡單搜尋上明顯拖慢反應時間。

新版本則導入混合式搜尋機制,當使用者輸入查詢時,會先透過Google Photos原本的圖像辨識系統回傳快速初步結果,例如尋找特定人物、動物或場景的照片,在背景則繼續啟動Gemini AI模型,藉此處理更複雜的推論任務,最後再補上完整回答。

這樣的設計一方面能讓常見搜尋能即時顯示,也保留AI深度理解的優勢,改善使用者過去需點選多層選單、等待冗長處理的體驗問題。

使用條件與支援範圍

目前Ask Photos功能僅在美國地區重新開放,同時必需符合下列條件才會顯示此功能:

• 使用者年滿18歲

• Google帳戶語言設為英文

• 啟用Google Photos的「Face Groups」功能

這項功能仍維持聊天式介面設計,用戶可直接輸入如「去年生日去的壽司店是?」,或是「我車子的車牌是多少?」等語意化提問,系統會根據照片內容、時間與地點等中繼資料進行推論,甚至分析圖片中文字、識別建築物或招牌等細節資訊給出答案。

多層搜尋結構,補足智慧與效率

為回應用戶對傳統搜尋速度的需求,新版本將原先的「僅AI回應」策略轉變為「AI + 傳統」雙引擎設計。

例如:

• 輸入「Max 的照片」:系統會先顯示 Max 的人臉分類結果,再補上與 Max 相關的事件摘要

• 查詢「去滑雪的照片」:先出現雪景照片,稍後補上時間、地點和旅遊紀錄

• 問「生日那天去的餐廳叫什麼?」:AI 分析當天拍攝地點,推斷餐廳名稱

整體介面也不再取代原有搜尋列,而是整合在既有Photos搜尋中,提升直覺操作性與效率。

隨著Google不斷強化Gemini模型與搜尋體驗,Ask Photos將成為未來相片應用的一大亮點。除了找照片,AI搜圖也將進一步承擔「記憶助理」角色,幫助用戶從龐大的影像資料中快速抓取珍貴時刻與生活線索。至於後續是否擴及更多地區與語言版本,仍有待Google日後公布更新計畫。