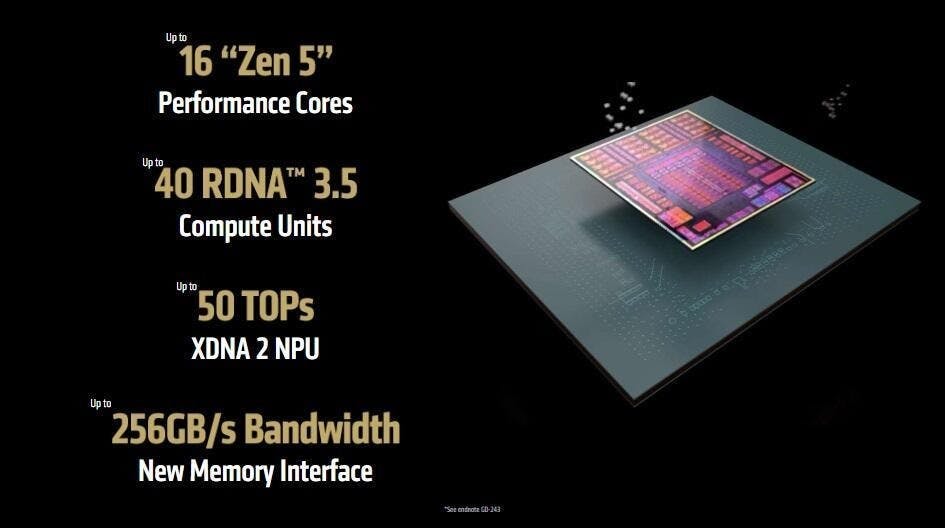

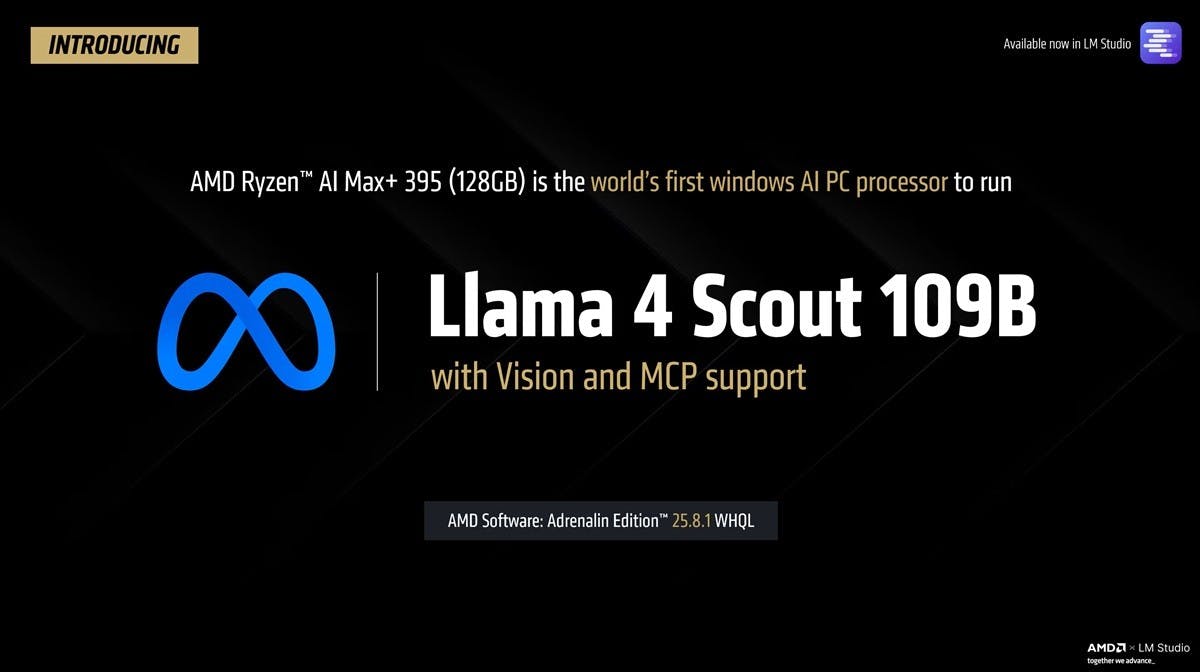

AMD於CES公布Ryzen AI Max處理器時展演在整合型處理器執行Llama 70b的大型語言模型,隨著AMD於2025年7月釋出Adrenalin Edition 25.8.1驅動,AMD進一步解放具128GB記憶體的Ryzen AI Max+ 395處理器的潛力,使這款GPU最大可分配到96GB記憶體的處理器足以執行128B參數的大型語言模型,並率先成為全球首款可執行Llama 4 Scoyt 109B混合模型的AI PC處理器。

Meta Llama 4 Scout 128B屬於混合專家模型(MoE),實際上是在128B參數中載有大量且多元的模型,僅在需要時使用約17B參數的內容,執行模型時並不需要執行完整的128B參數,不過由於所有模型都需存放在記憶體快取內,故仍需要充裕的記憶體空間存放模型。

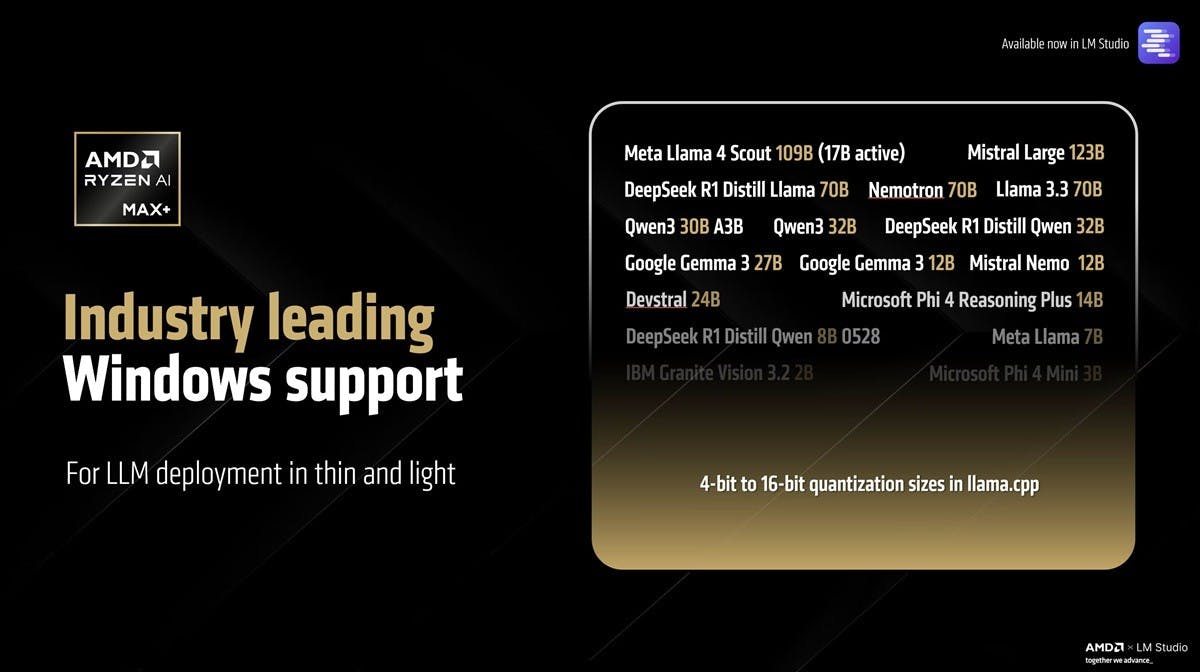

透過llama.cpp進行4-bit to 16-bit的量化壓縮後,即可把Meta Llama 4 Scout 128B模型存放在96GB記憶體空間內這;由於在執行時僅使用當中的17B參數,表示由於Meta Llama 4 Scout需要執行的模型實際尺寸不大,以Ryzen AI Max+ 395的運算力即可實現迅速的反應,每秒約可產生15個Token。

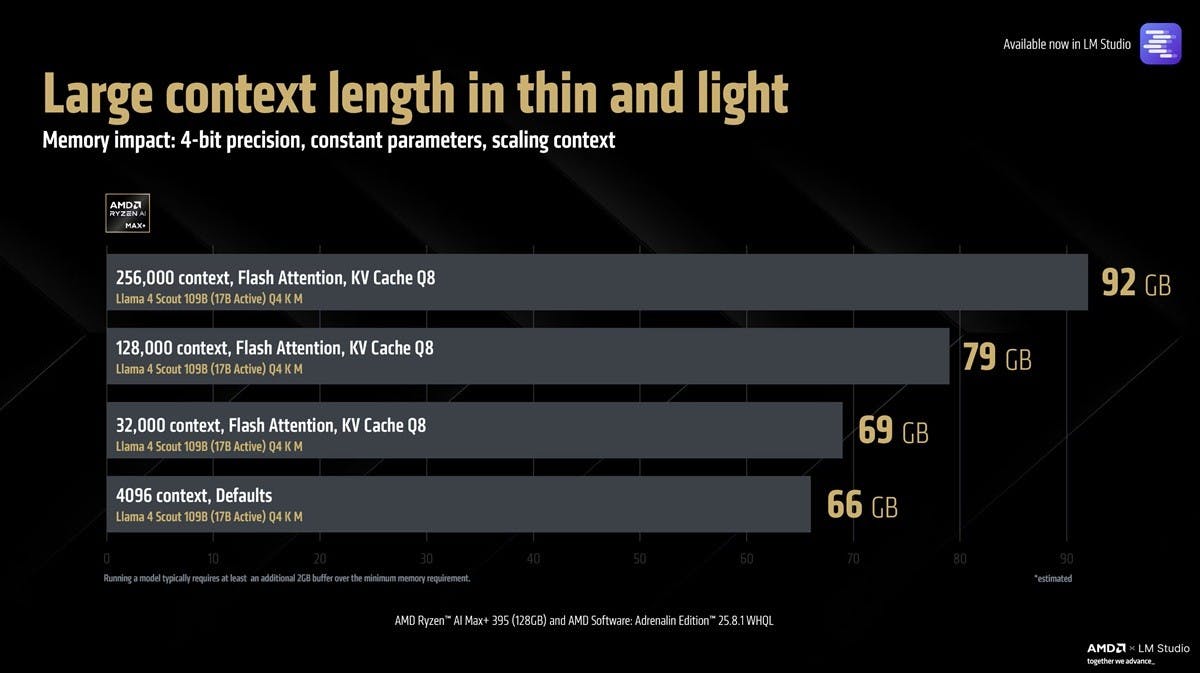

也由於運算性能、更大的記憶體,Ryzen AI Max+ 395另一項突破是能夠支援更大的上下文本,相較一般消費級處理器約可達4,096個Token,Ryzen AI Max+ 395則可實現達256,000個Token。