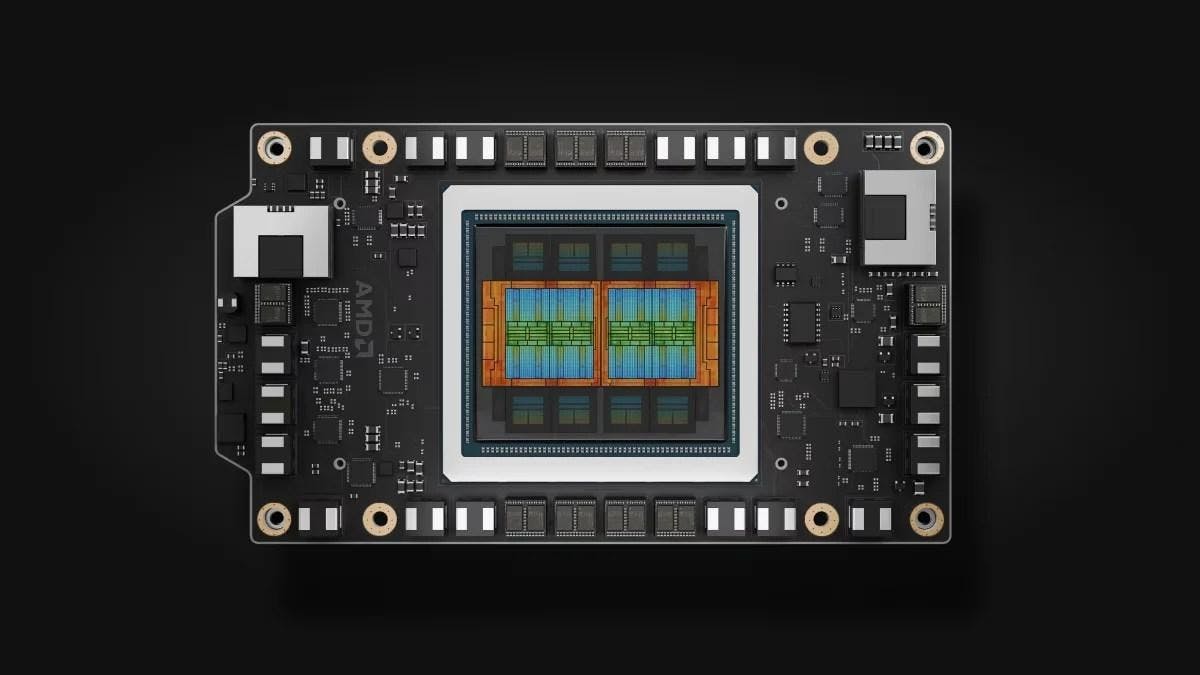

AMD 正式推出採 CDNA 4 架構的 Instinct MI350 加速器,瞄準 AI 推論應用,加強與 NVIDIA 競爭的實力。

在加州聖荷西舉辦的Advancing AI 2025活動中,AMD宣布正式推出換上CDNA 4架構設計、配置高達288GB HBM3e高頻寬記憶體的新一代高效能運算平台加速器Instinct MI350系列,標榜在人工智慧推論效能提升35倍 (相比Instinct MI300系列)。同時,AMD也再次強調Instinct MI400系列加速器則會在2026年推出,並且換上代號「Helios」的下一代人工智慧架構設計。

與NVIDIA在人工智慧加速推論需求抗衡

Instinct MI350系列區分Instinct MI355X、Instinct MI350X設計,兩者均採用CDNA 4架構設計,並且都搭載由美光、三星提供的288GB HBM3e高頻寬記憶體,支援每秒8TB的資料傳輸速率,差異性則各有不同,例如Instinct MI355X在FP64峰值算力可達79TFLOPS,FP4算力表現可達20PFLOPS,而Instinct MI350X則分別可達72TFLOPS、18.4PFLOPS。

另外,Instinct MI355X對應熱設計功耗最高為1400W,Instinct MI350X最高則是1000W。

而兩者均採OAM模組設計,並且支援水冷或風冷散熱架構,在風冷架構下最多可配置64組GPU,水冷架構下則可增加至128組GPU,強調相比NVIDIA的GB200 NV72能配置更多GPU進行運算加速,而配置記憶體容量也比GB200 NV72更多,在峰值算力表現也在FP4、FP8運算超越GB200 NV72。

不過,相較NVIDIA的GB200 NV72採用Arm架構設計的Grace CPU,AMD在其運算架構配置的是x86架構設計、代號「Turin」的第五代EPYC伺服器處理器,並且搭配可擴充傳輸頻寬、代號「Pollara」的Pensando網路介面控制器,同時也相容OCP開放運算架構,預計應用在甲骨文的Oracle Cloud Infrastructure (OCI),以及更多超大規模雲端供應商服務平台。

以ROCm 7.0版本開源人工智慧軟體平台提升人工智慧推論能力、建構開發者雲端託管環境

配合新推出的Instinct MI350系列加速器,AMD也宣布推出ROCm 7.0版本開源人工智慧軟體平台,標榜讓人工智慧推論能力提升高達3.5倍,並且支援FP4運算格式與FA3 (Flash Attention 3)演算法,使得vLLM虛擬大型語言模型、SGLang等開源框架能已更快速運作。

同時,AMD也宣布啟用開發者雲端託管環境,透過無須事先設定即可使用的Docker容器平台、立即可用的vVLLM、SGLang、HAO AI Lab等技術資源,讓開發者更容易藉由ROCm軟體堆疊與AMD GPU打造各類應用服務。

Instinct MI400系列加速器、代號「Helios」的機架配置設計

AMD更再次預告將於2026年接續推出Instinct MI400系列加速器,並且提出代號「Helios」的機架配置設計,其中將整合Instinct MI400系列加速器與AMD代號「Venice」的下一代EPYC伺服器處理器,以及採Zen 6架構設計、代號「Vulcano」的Pensando網路介面控制器,藉此與NVIDIA日後接續推出的人工智慧機架設計抗衡。

諸多業者宣布與AMD合作

在此次活動上包含Meta、OpenAI、微軟和xAI等業者均表示採用AMD解決方案推動人工智慧應用:

• Meta詳述如何廣泛部署Instinct MI300X於Llama 3和Llama 4推論。Meta對於MI350及其運算能力、每總體擁有成本(TCO)的效能表現,以及新一代記憶體感到非常振奮。Meta將持續與AMD密切合作,推動AI藍圖,其中包括Instinct MI400系列平台的相關計畫。

• OpenAI執行長Sam Altman闡述硬體、軟體與演算法全面最佳化的重要性,並強調OpenAI與AMD在AI基礎設施方面的緊密合作,包括採用MI300X開發Azure研究及GPT模型,以及在MI400系列平台上的深度設計合作。

• Oracle Cloud Infrastructure (OCI)是首批採用搭載AMD Instinct MI355X GPU之AMD開放式機架級AI基礎設施的業界領導者之一。OCI運用AMD CPU和GPU為AI叢集提供平衡、可擴展的效能,並宣布將推出由最新AMD Instinct處理器加速的Zettascale AI 叢集,搭載高達131,072個MI355X GPU,協助客戶實現大規模的AI建構、訓練和推論。

• HUMAIN分享其與AMD簽訂的里程碑式協議,旨在運用唯獨AMD才能提供的全方位運算平台,建構開放、可擴展、具彈性且具成本效益的AI基礎設施。

•微軟宣布Instinct MI300X現已為在Azure上專屬和開源模型提供生產力。

•Cohere指出其高效能、可擴展的Command模型已部署在Instinct MI300X上,以高吞吐量、效率和資料隱私為企業級LLM推論提供動能。

•Red Hat描述其與AMD擴大的合作如何實現生產就緒的AI環境,透過Red Hat OpenShift AI上的AMD Instinct GPU,在混合雲環境中提供強大、高效率的AI處理。

•Astera Labs強調開放的UALink產業體系如何加速創新並為客戶帶來更大的價值,並分享了提供全面的UALink產品組合以支援新一代AI基礎設施的計畫。

•作為UALink聯盟的成員,Marvell與AMD攜手合作共同開發開放的互連技術,為AI基礎設施帶來極致的靈活性。