作為全球超級電腦指標的 TOP500 稍早公布全新的榜單排名,此次在前 500 大系統當中,有高達 342 套系統使用 NVIDIA 的加速運算,其中 58 套入圍的新系統有 41 套採用 NVIDIA 的加速運算,前 10 大超級電腦系統當中有 8 套採用 NVIDIA 加速技術;此外,採用 NVIDIA 的超算系統也在節能榜單表現亮眼,在 GREEN 500 的前 40 名有 35 套採用 NVIDIA 加速技術、前 10 名僅有一套非 NVIDIA 加速技術。

值得注意的是採用 InfiniBand 連接的系統也比去年提升 20% ,意味著新一代系統由於處理 AI 、 HPC 與類比資料的增加,對於降低網路延遲較過往更為重視;這些新系統也包括微軟新一代 Azure 雲端系統、劍橋大學的 Wilkes 以及特斯拉的 AUTOMOTIVE 。

微軟新一代的 Azure 是提供公有雲服務的超算系統,此次一口氣以四套系統佔據 TOP500 自 26 位到 29 位,這四套 Azure 系統皆可提供高達 16.59 petaflops 的 Linpack 性能。微軟新一代 Azure 在每個虛擬實例提供達 8 個 A100 Tensor Core GPU ,多個實例之間以 HDR 200G InfiniBand 連接,共可在雲服務與高達數千個 GPU 進行高速連接。

而劍橋大學此次以 Wilkes-3 成為當前學術單位性能最高的超算系統,同時也是當前 GREEN 500 的第三名, Wilkes-3 更是一套雲原生超算系統,使研究人員可共享高度安全與隱私的虛擬資源。 Wilkes-3 在架構導入 BlueField DPU 提供安全、虛擬化與數據管理應用,並透過 320 個以 HDR 200G InfiniBand 連接的 A100 GPU 。

▲今年 NVIDIA 在超算領域表現依舊亮眼, TOP 500 前 10 有 8 套入圍、 GREEN 500 前十則僅有一套非 NVIDIA 系統

同時,從許多新落成的超算系統架構,亦可感受到除了加速運算外, AI 在超算領域日益受到重視,如美國國家能源研究科學計算中心的 Perlmutter ,就已達 6,144 個 A100 GPU 、 64.59 Linpack petaflops 表現取得 TOP500 的第 5 位,更重要的是 Perlmutter 在 AI 的表現, Perlmutter 貢獻當前最新版本的 HPL-AI 達一半的性能,並在提供目前深度學習、科學計算與商業計算所需的混合精度計算的同時,仍可提供雙精度運算。

佛羅里達大學的 HiPerGator AI 以 17.20 奪下 Top 500 的 22 位,同時與第一位僅 0.18 Gflops / Watt 之差為當前超算節能指標 Green 500 的第二名。而 Perlmutter 也是藉由模組化的 NVIDIA SuperPOD 構成。

位於盧森堡 MeluXina 超算系統是此次位於歐洲的新進榜系統,並首次入圍即以 10.5 Linpack petaflops 取得第 37 名的排名;而英國的劍橋一號則以 9.68 TFLOPS 取得 TOP 500 的第 42 名,也是當前英國最強大的超算系統。另外瑞典的 BerzeLiUs 則以 5.25TFLOPS 取得第 83 位,專注於 HPC 、 AI 、資料分析,藉由 200G InfiniBand 連接達 60 套 NVIDIA DGX 系統。

在純 AI 運算領域,作為當前 HPC 之 AI 算力基準的 HPL-AI 也在此次有顯著的變化,相較去年 6 月公布的榜單,前 10 名系統的 HPL-AI 得分成長近 5 倍,其一關鍵就是 2020 年 3 月所公布全新的代碼;這項新代碼能夠消除系統之 GPU 與 GPU 溝通等待 CPU 決策的時間,並採用於 AI 效率更高的 16bit 代碼而非 Linpack 預設的 32bit 代碼,一舉使 AI 運算效率提高。例如橡樹嶺國家實驗室的系統,也因為導入全新針對 AI 運算的代碼自 2019 年的 445 TFLOPS 提升到 1.15 exaflops 的 HPL-AI 得分。

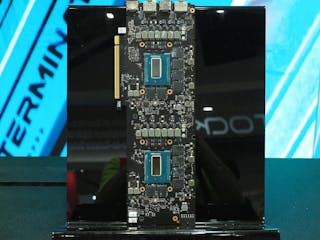

而 Tesla 特斯拉雖然已經不再車輛的自動駕駛平台使用 NVIDIA 的 DRIVE 技術,不過 Tesla 為了自動駕駛的 AI 模型訓練與開發,仍建構一套達 720 個節點、每個節點有 8 張 NVIDIA A100 Tensor Core GPU 的 AUTOMOTIVE 超級電腦,達到 1.8 exaflops 性能,並為 TOP500 的第 5 名。

3 則回應

tesla 居然不是拿自己的HW3晶片去堆疊

畢竟以他的產車量而言,開IC其實很吃力