Intel 將於台灣時間 3 月 29 日深夜 11 點 30 分舉辦英特爾資料中心及 AI 投資者網路研討會,而在活動開始前夕, Intel 搶先公布一則生成式 AI 的內容,說明 Intel 如何應對生成式 AI 的運算與永續效能挑戰,同時也允諾持續推動 AI 民主化與支持開放生態系的願景。 intel 也多次強調相較 NVIDIA 的 A100 加速器, Intel 的 Gaudi 系列加速器更具能源效益與性價比。

具有模仿人類產生內容的生成式 AI 將會改變人類的生活型態,同時也為資料中心帶來 AI 運算的挑戰; Intel 強調在相關領域投入大量的資源與資金,希冀未來每個使用者都能輕鬆使用生成式 AI ,同時也希冀生成式 AI 須建立在值得信任、透明與多元選擇的開放生態系。

雖然生成式 AI 已經推出好一陣子,結合 GPT-3 與 DALL-E 等語言模型的生成式 AI 並非近期才出現,然而由於趨近真人對話流暢度的 ChatGPT 的出現,讓世人首度感受到生成式 AI 的時代來臨;不過為了使生成式 AI 能邁向下一步,以開放與異構運算的生成式 AI 系統是最佳解,而一個開放的生態系需要使開發者能夠於任何地方建構與部署 AI 的同時考慮 AI 的可能性、價格與效能。

Intel 將藉由此次英特爾資料中心及 AI 投資者網路研討會進行多項相關領域的公布,其中包括 Intel 如何透過對當前流行的開源框架、函式庫與工具提供最佳化,並確保能對生成式 AI 具備最佳化的硬體效能與降低複雜性。

Intel 也引述機器學習的開源資料庫的結果,在執行具備達 1,760 億個參數的 BLOOMZ 的 LLM 大型語言推論模型時, Intel 的 Habana Gaudi2 的執行效能相對當前業界最廣泛的 NVIDIA A100 80GB 快了 20% 。 BLOOM 是能夠處理 46 種語言與 13 種程式語言的 LLM ,同時是在完全透明的情況之下完成的模型。

另外在更簡化的 70 億個參數的 BLOOMZ 推論模型的情況, Gaudi 2 則相對 NVIDIA A100 80GB 快了三倍,另外第一世代的 Habana Gaudi 則相對 NVIDIA A100 80GB 具有更好的價格效能比; Intel 強調 Hugging Face Optimum Habana 函式庫僅需變動少數的代碼,即可在 Gaudi 系列加速器部署這些 LLM 。

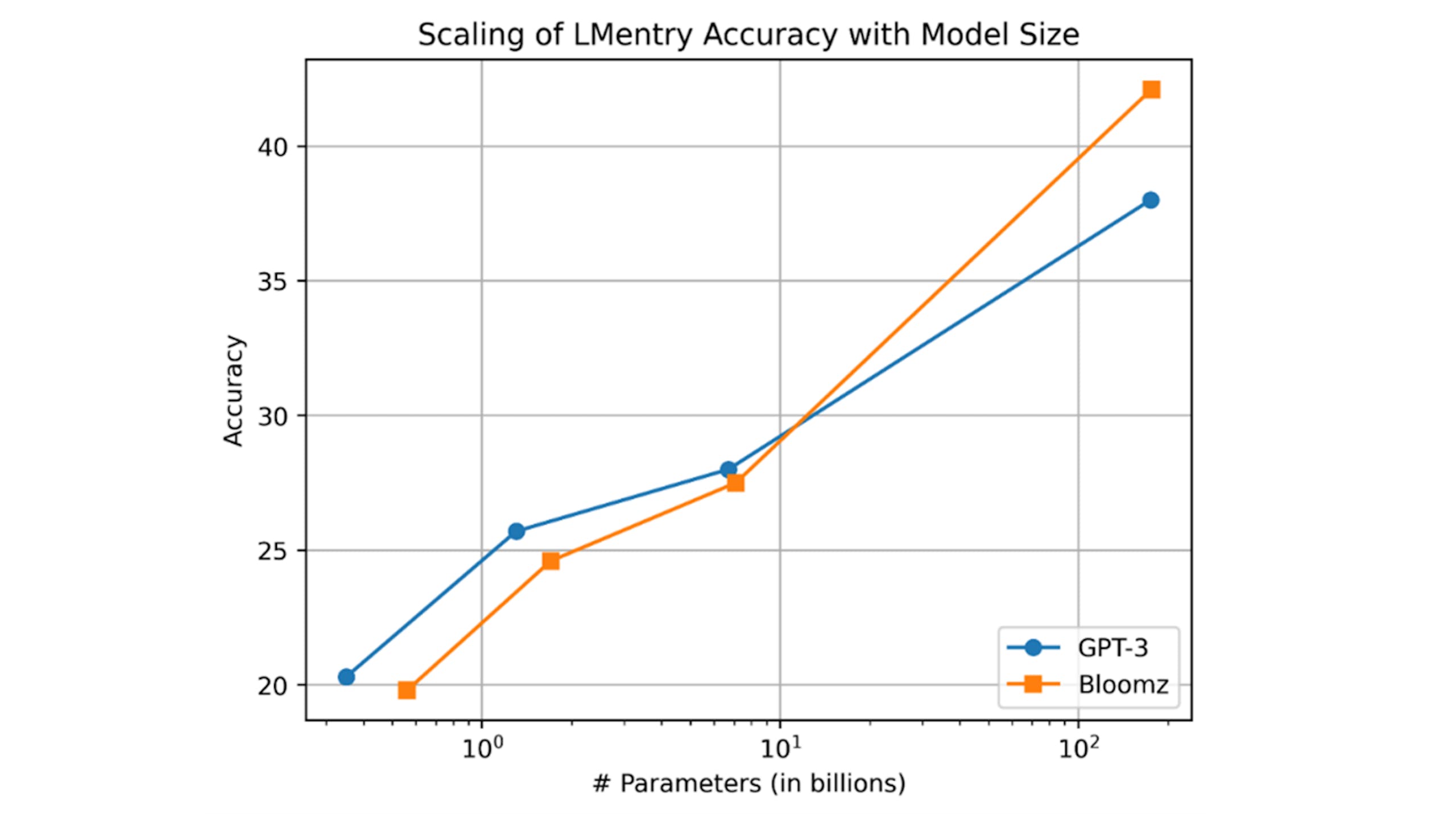

▲ 在 176 億個參數下的 BLOOMZ 模型精度優於相近大小的 GPT-3

此外 Intel 實驗室研究員還透過 Gaudi2 於零樣本設定進行 LEntry 評估 BLOOMZ , LMEntry 式近日提供的新一代語言模型基準,而 BLOOMZ 的精度隨模型大小的變化酷似 GPT-3 ,最大 176 億個參數的 BLOOMZ 模型的精度優於相近大小的 GPT-3 。

同時 Hugging Face 也分享透過最先進文本至圖像的生成式 AI 模型,是由 Stability AI 的 Stable Diffusion ,也是 DALL-E 的開源替代方案;藉由具備 Intel AMX 高階矩陣擴充、代號 Sapphire Rapids 的第 4 代 Xeon Scalable 處理器,在不需變動任何代碼即可提升 3.8 倍的處理速度;另外透過 Intel Extension for PyTorch 的機器學習自定義格式 Bfloat16 ,則能再進一步提高 2 倍的自動混合精度,將原本 32 秒的延遲縮減至 5 秒。

第 4 代 Xeon Scalable 所具備的異構混合加速架構與 Intel 的 OpenVINO 相互結合下,能夠進一步穩定擴散推論,相較第 3 代 Xeon Scalable ,第 4 代 Xeon Scalable 的效能幾乎提升 2.7 倍;同時透過 OpenVINO 的 Optimum Intel 工具,能夠加速 Intel 架構的端到端流水線,使平均延遲減少 3.5 倍,基礎效能提升與延遲降低相互結合之下,使整體效能提升達 10 倍。

Intel 也再次提到其產品組合與競爭對手 NVIDIA A100 相較之下的優勢,新一代的 Gaudi2 延續 Gaudi 價購,其性價比相較 AWS 上以 NVIDIA A100 的實例高出 40% ,同時用於執行機器視覺負載相對 A100 高出 1.8 倍每瓦效能。同時第 4 代 Xeon Scalable 也提供顯著的世代升級,借助 AMX 等整合加速器,在 AI 工作附載實現 10 倍的推論與訓練效能提升,並較前一代產品提高 14 倍的每瓦效能。

最後 Intel 也重申生成式 AI 雖是能支持與強化人類能力的強大工具,但系統開發與佈署仍須回歸到以人為本,需肩負負責任的 AI 倫理,確保系統在不損害道德的前題發揮其潛力;保護 AI 倫理最佳方式是透過一個開放生態系促進訓練與資料庫的透明度,確保具透明度的 AI 供應鏈能夠在負責任的前提開發 AI 。

Intel 將透過民主化運算與工具支援建構 LLM ,並降低成本與提高公平性,舉例來說, Intel 正專注於提供 ALS (肌萎縮側索硬化症)患者使用的 LLM ,使他們能夠更有效的進行溝通。