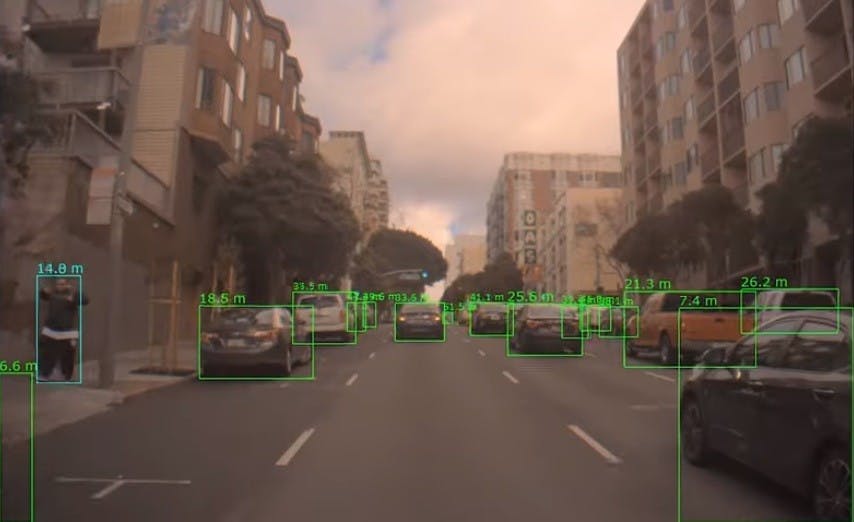

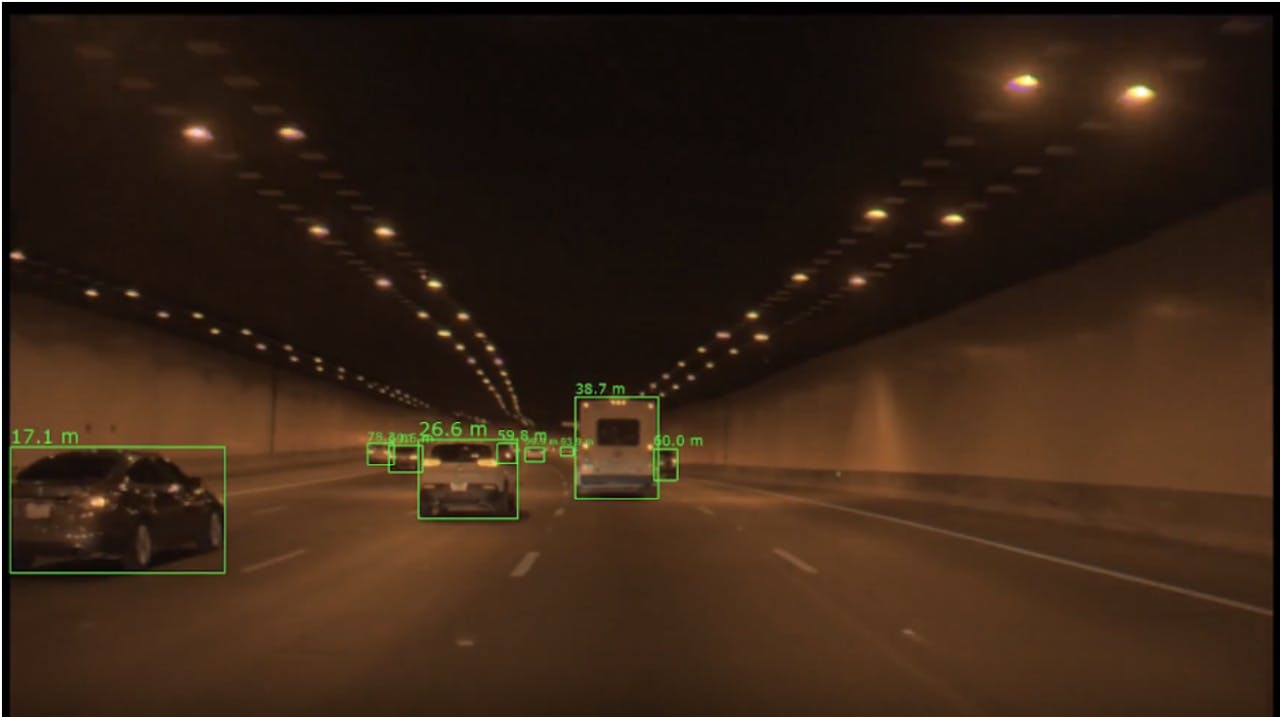

對開車的人來說,抓準車輛與其它路上的人、事、物的距離是相當重要的大前提,這對於有著一雙足以讓大腦建構 3D 空間、具高解析度的眼睛的人類而言看是相當簡單的,不過若要在自動駕駛判讀正確的距離,即便是搭載模擬眼睛的雙相機也沒那麼容易。

這是由於自動駕駛系統所搭載的雙相機雖然可如人眼一般建構 3D 空間,但卻可能因為影像訊號不同不,導致資訊落差後,使得距離評估失準,其實這樣的情況就如同 3D 頭盔為何要設定在超越人眼理論更新率的 90fps 的情形類似。

NVIDIA 的研究人員正在進行一項研究,他們希望透過單一相機所得到的平面影像就能推估正確的 3D 距離;單鏡頭的測距技術在輔助駕駛並不是新鮮事,不過早期的技術只能判讀在相同平面的相對距離,在於一旦前方的物體的位置有高有低,就無法透過正確的方式得到正確的資訊,當上坡就會得到比實際遠的錯誤資訊,如此一來很容易引發自動駕駛失靈、緊急煞車故障等狀況。

當然畢竟是 NVIDIA 的研究計畫,如何活用 AI 技術就是它們的強項, NVIDIA 研究團隊利用捲積神經網路與單鏡頭資訊,透過 DNN 把雷達、光達所獲取的真實世界距離數據用來搭配影像進行 AI 模型訓練,藉此建構能夠因應上下坡變化的單鏡頭測距模型。

新聞來源: NVIDIA Blog