隨著代號 Sapphire Rapids 的 Intel 第四代 Xeon Scalable 處理器正式公布, NVIDIA 也同步宣布將有包括 NVIDIA DGX H100 與合作夥伴設計共超過 60 款以上加速系統問世,強調相較傳統資料中心高出 25 倍執行效率,能夠大幅節省能源成本。

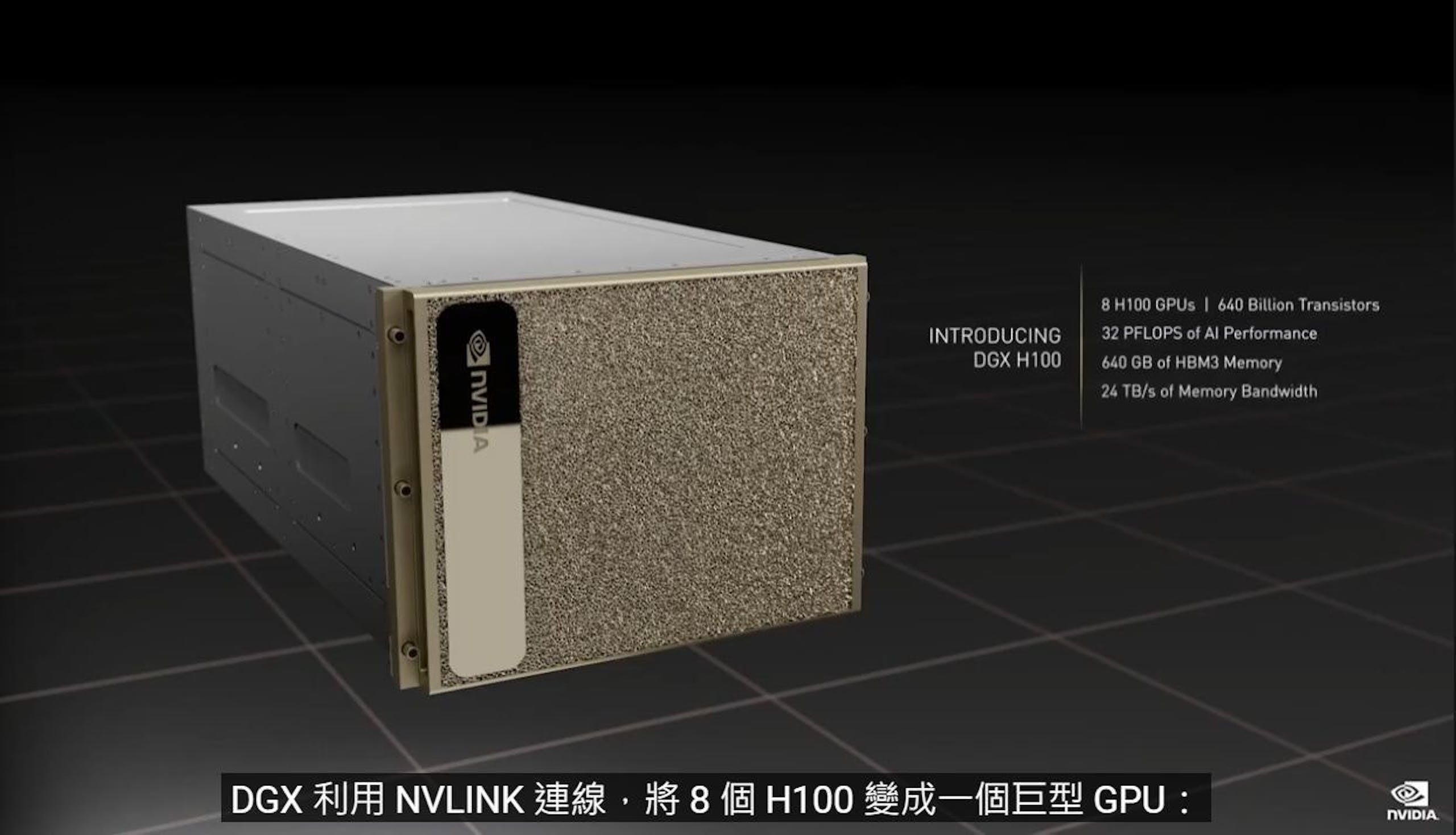

▲ NVIDIA DGX H100 不僅純性能提升,更具備更出色的能源效率

NVIDIA H100 不僅具備創新的硬體架構與達 900GB/s 的 NVLink ,也率先支援 PCIe 5.0 通道,提供更高速的 GPU 與 CPU 的溝通管道,相較前一代架構的加速系統,採用 NVIDIA H100 的系統在 AI 訓練與 HPC 作業附載高出 9 倍以上,在訓練速度與推論的能源效率提升達 3.5 倍,同時相較僅使用 CPU 的傳統資料中心高出 25 倍效率,若使用純 x86 架構伺服器需要訓練達 40 天的語言模型,在 NVIDIA DGX H100 僅需 1 到 2 天的時間,能進一步有效善用電力,並降低 AI 資料中心總持有成本。

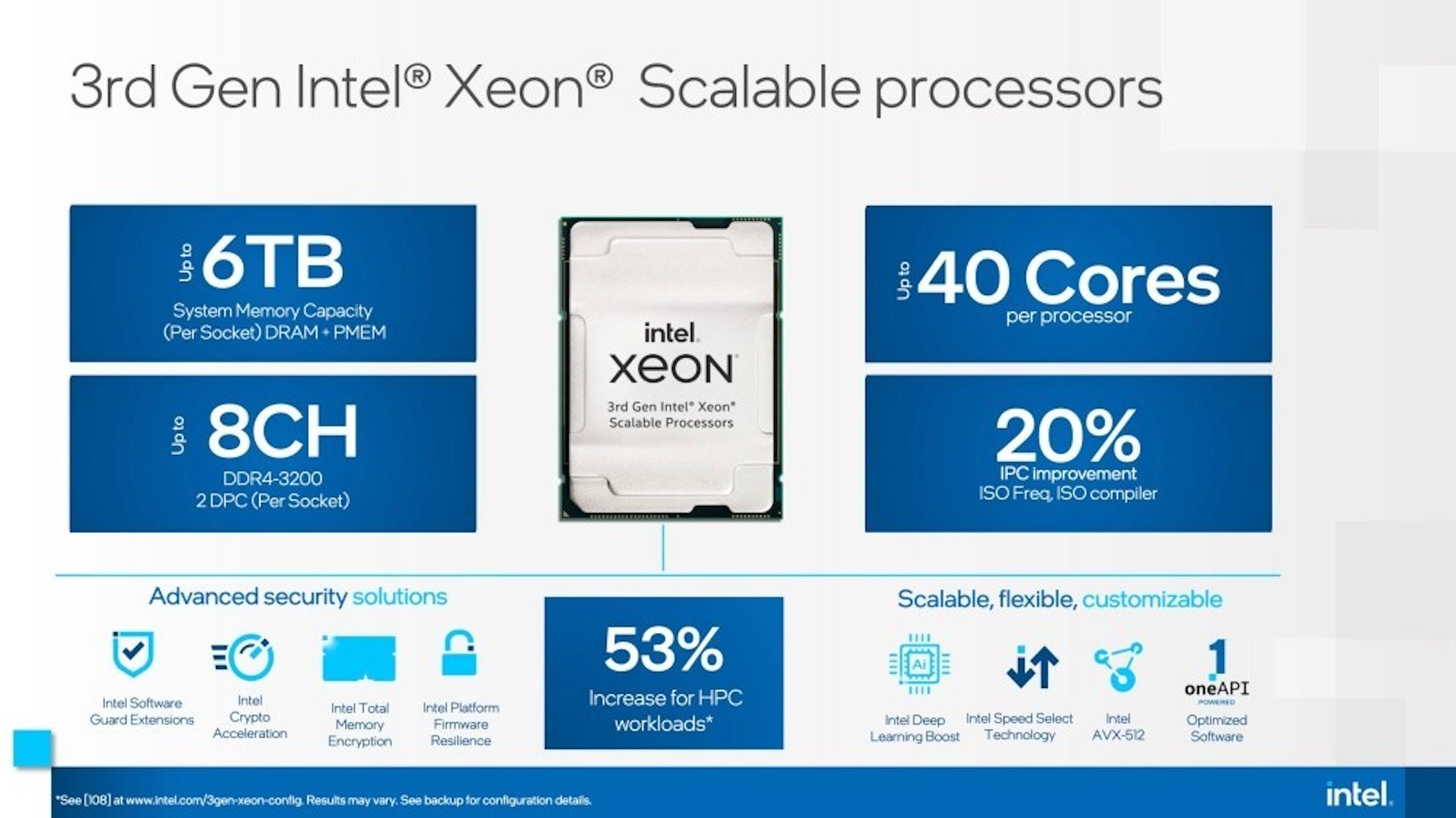

▲第四代 Xeon Scalable 處理器的 PCIe Gen 5 頻寬帶來更快速的 CPU 、 GPU 與網路連接,同時更多的通道也允許更高密度的 GPU 與高速網路

Intel 第四代 Xeon Scalable 處理器對加速運算做重要的是提供 PCIe Gen 5 介面,相較上一世代系統提供的 PCIe Gen 4 介面大幅提升一倍傳輸速率,無論是對 CPU 至 GPU 乃至網路都可獲得更高的頻寬,同時更多的 PCIe 通道也有助每台伺服器部署更高密度的 GPU 與高速網路。

此外第四代 Xeon Scalable 具備更高速的記憶體頻寬,也將挹注如 AI 等資料密集工作負載更佳的表現,此外透過達 400Gbps 的網路速度亦可使資料中心系統的伺服器與儲存裝置更快速進行資料傳輸。

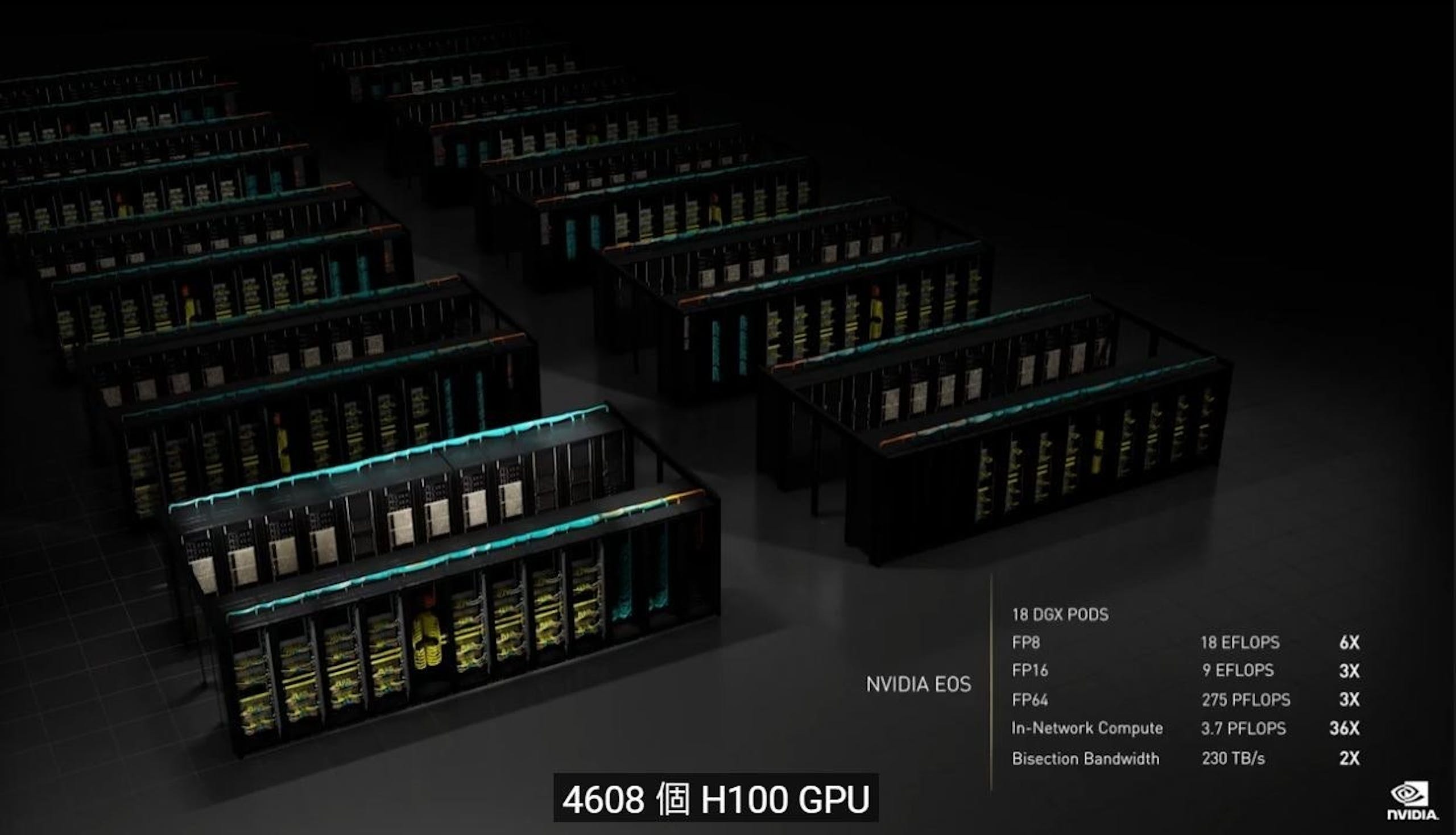

▲借助 NVIDIA DGX SuperPOD 能實現達 1 exaflop 以上的 AI 效能

以 NVIDIA DGX H100 為例,每個 DGX H100 配有 2 個第四代 Xeon Scalable 處理器,透過 PCIE Gen 5 連接 8 個 NVIDIA H100 GPU , 10 張 NVIDIA ConnectX-7 乙太網路介面卡,可提供大型生成式 AI 、大型語言模型與推薦系統充裕的效能。此外也能藉由 NVIDIA DGX SuperPOD 串接多套 NVIDIA DGX H100 ,使 AI 效能達 1 exaflop 效能。

除了 NVIDIA DGX H100 ,包括華碩、源訓、 Cisco 、 Dell 、富士通、技嘉、慧與、聯想、昀達 QCT 與美超微等合作夥伴共同推出的 60 款以上採用 Intel 第四代 Xeon Scalable 與 NVIDIA H100 的系統皆具備 NVIDIA AI Enterprise 使用授權,提供採用端到端技術且安全的雲原生 AI 開發與佈署軟體,並提供包括參考應用程式、框架、預訓練模型與基礎設施最佳化 AI 工作流程,供企業 AI 提供具高效開發的完整平台。

同時基於第三代 Xeon Scalable 與 NVIDIA H100 的 Lenovo ThinkSystem 組成的 Flatiron Institute 超級電腦是目前 Green500 榜單新榜首,也預期將 CPU 平台提升至第四代 Xeon Scalable 的新一代 NVIDIA H100 加速系統能夠具備更突破性的能源效率。