NVIDIA加速運算成全球新一代超級電腦主流設計,超過七成的TOP500系統使用NVIDIA GPU

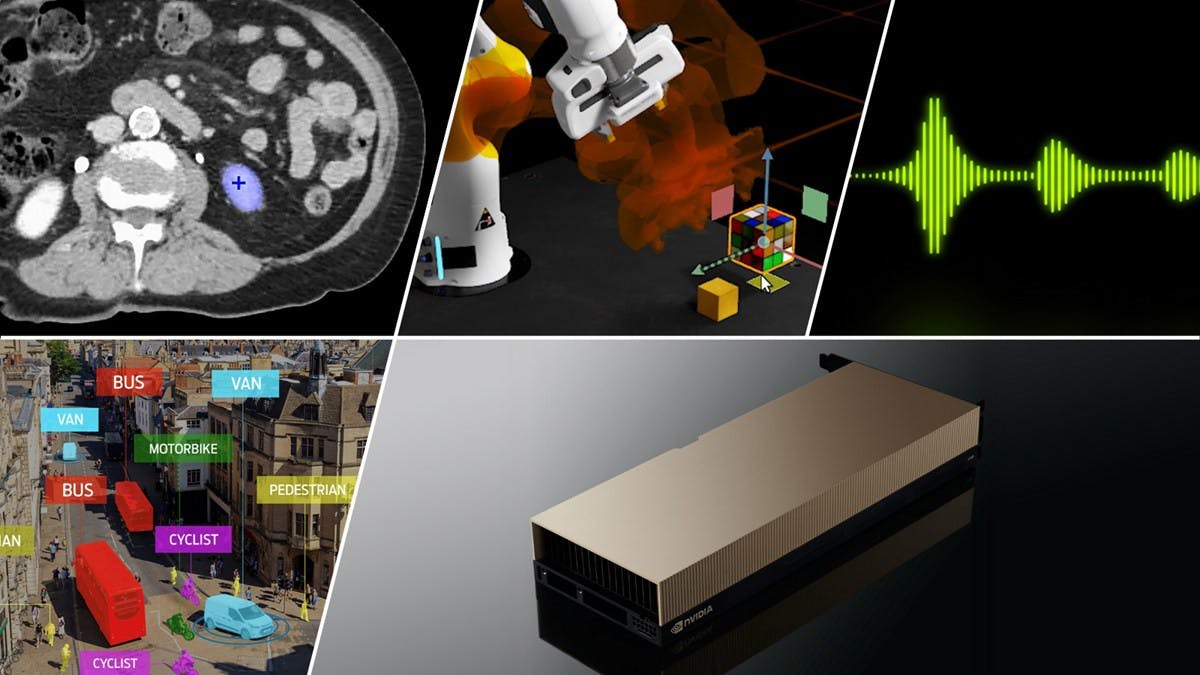

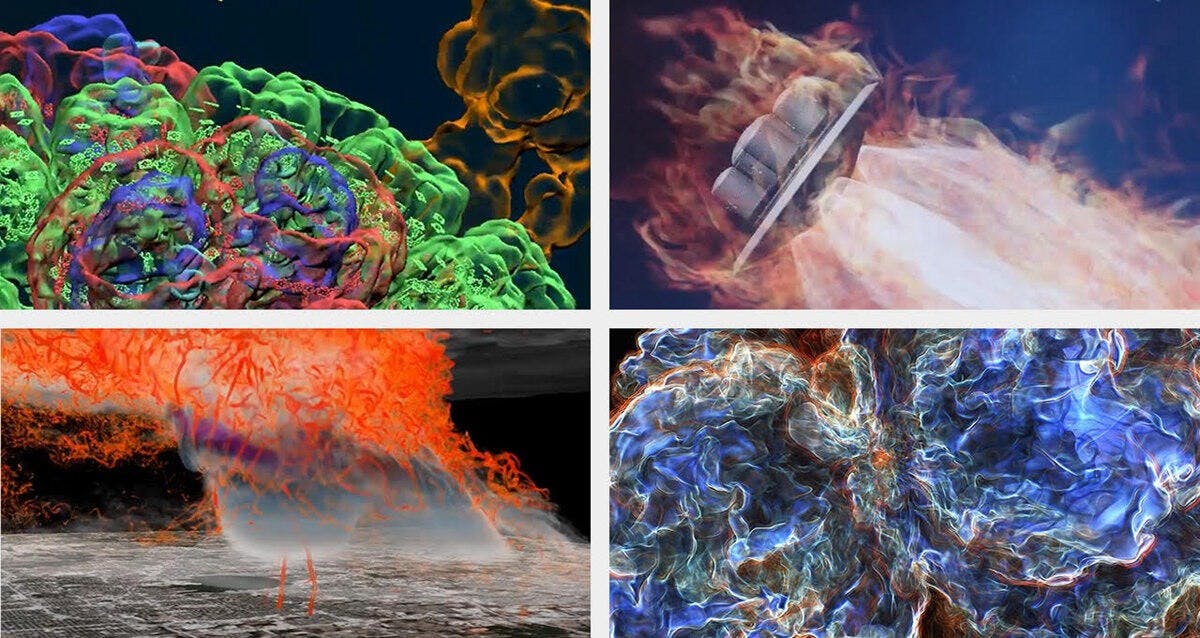

NVIDIA的加速運算技術可說是驅動近年超級電腦產業性能大幅提升的重要原動力,也由於出色的實績使得許多新建超級電腦系統紛紛採用NVIDIA的加速技術提升運算性能;於2024年11月公布的最新的TOP500超級電腦榜單上,達384套系統採用NVIDIA的技術,同時新入榜的53套系統中有46套為加速系統、當中達85%為NVIDIA Hopper GPU所驅動;更值得注意的是象徵能源效率的Green500榜單的前10名,有8名為NVIDIA GPU所加速的系統。 使NVIDIA加速系統廣受歡迎的關鍵不僅止於硬體的FLOPS運算性能數據,在基於開放的原則下,不斷透過軟體提升效率與增添新的可能性是NVI

8 個月前