Red Hat 啟動 LLM-D 社群專案 加速大規模分散式生成式 AI 推論

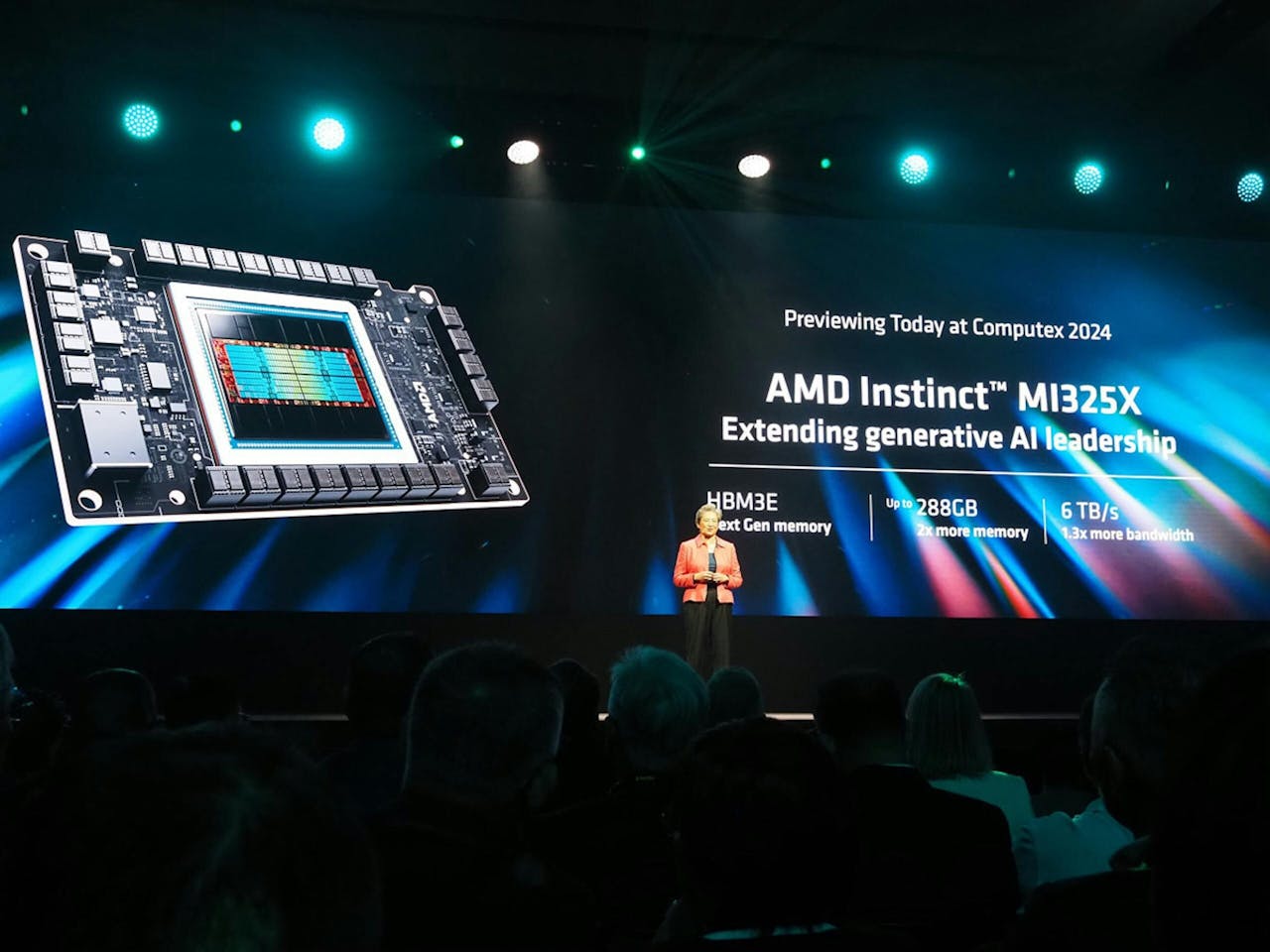

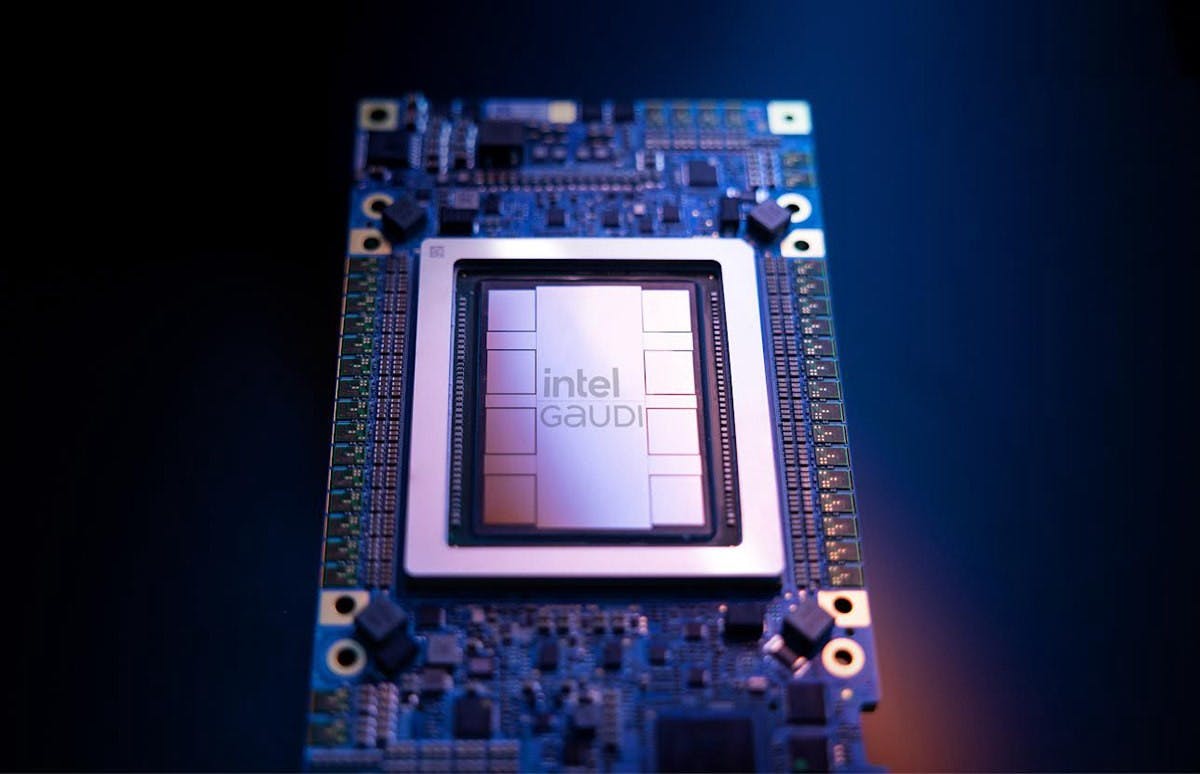

Red Hat 發表 llm-d 開源社群,結合 vLLM 與 Kubernetes 架構,致力於實現大規模分散式生成式 AI 推論,提升企業部署效率與彈性。 Red Hat近期宣布推出全新開源專案llm-d,旨在回應未來生成式AI (Gen AI)最關鍵的大規模推論需求。 此專案由創始貢獻者CoreWeave、Google Cloud、IBM Research與NVIDIA共同發起,並且獲得AMD、Cisco、Hugging Face、Intel、Lambda和Mistral AI 等業者,以及加州大學柏克萊分校和芝加哥大學等學術機構參與,目標讓生產環境中的生成式AI應用像Linux一樣無所

1 個月前