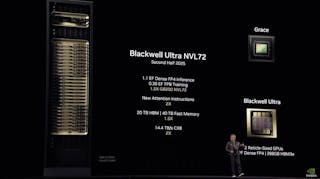

NVIDIA Blackwell正式於MLPerf Inference基準測試活動亮相,於Llama 2 70B推論性能提升4倍

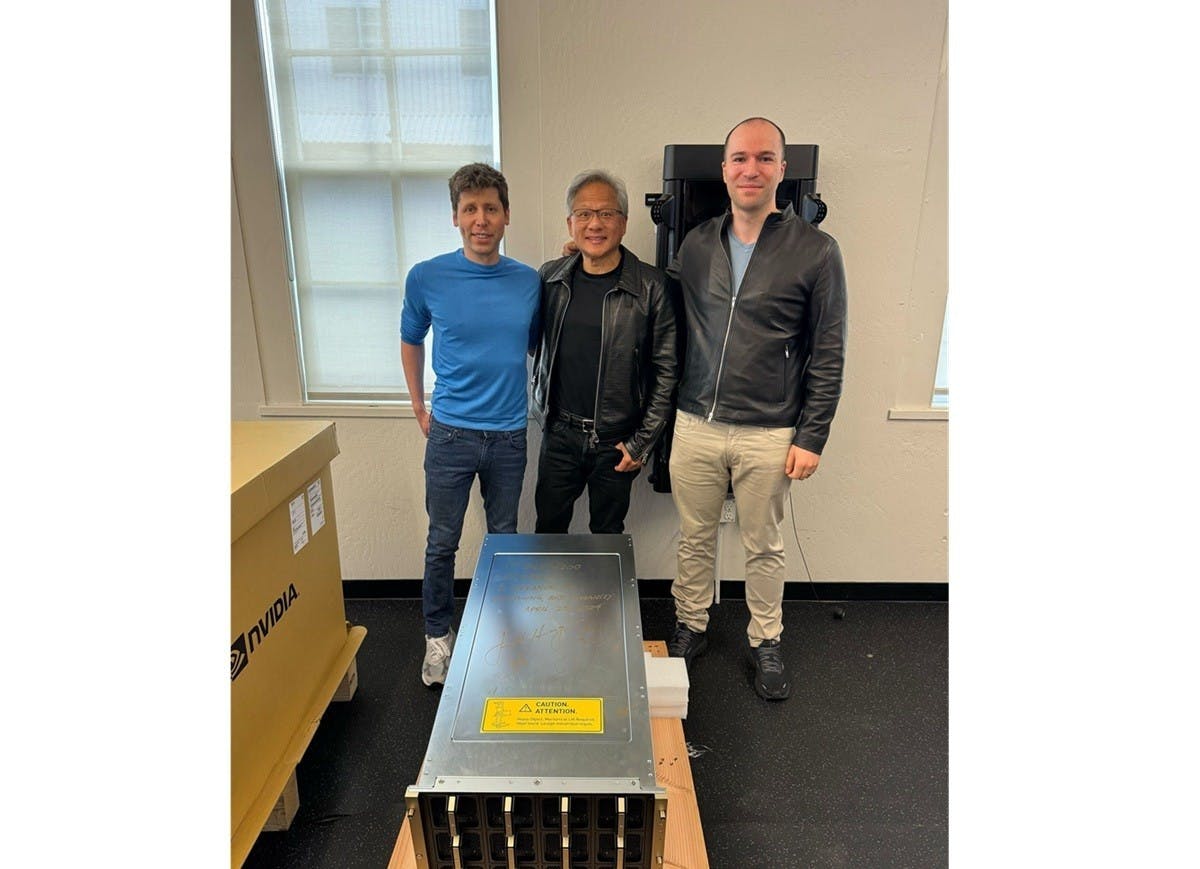

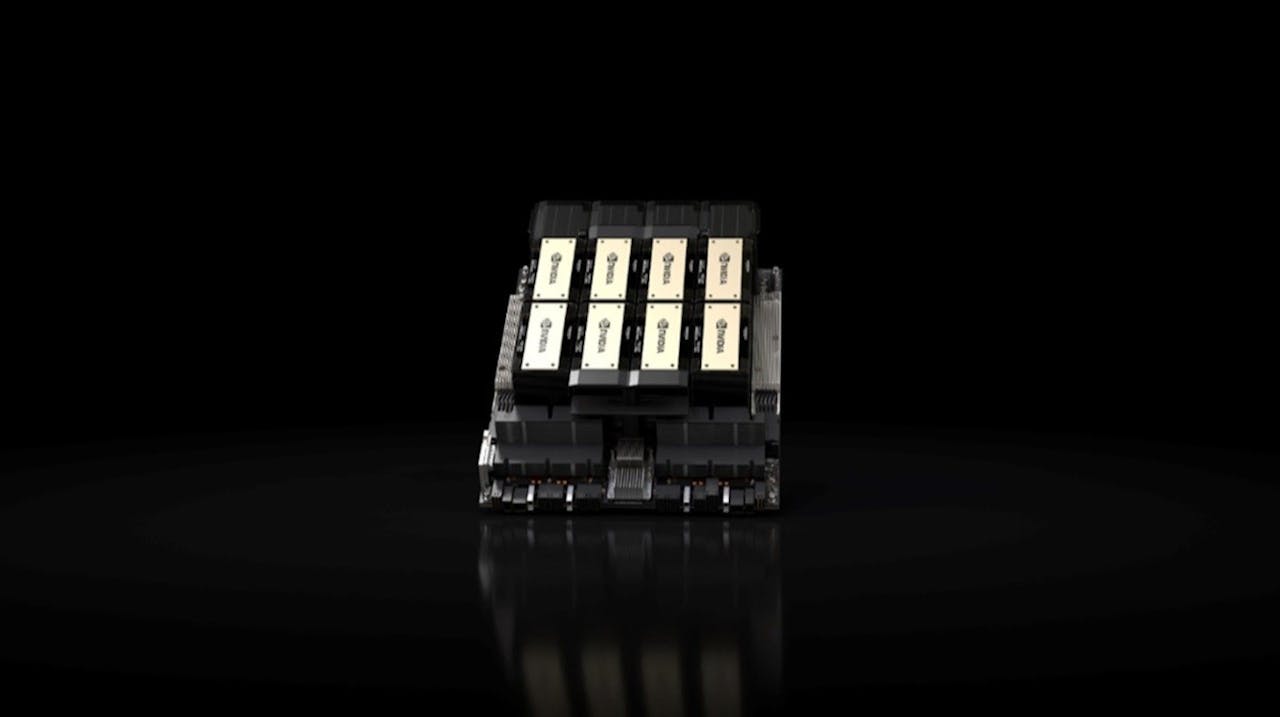

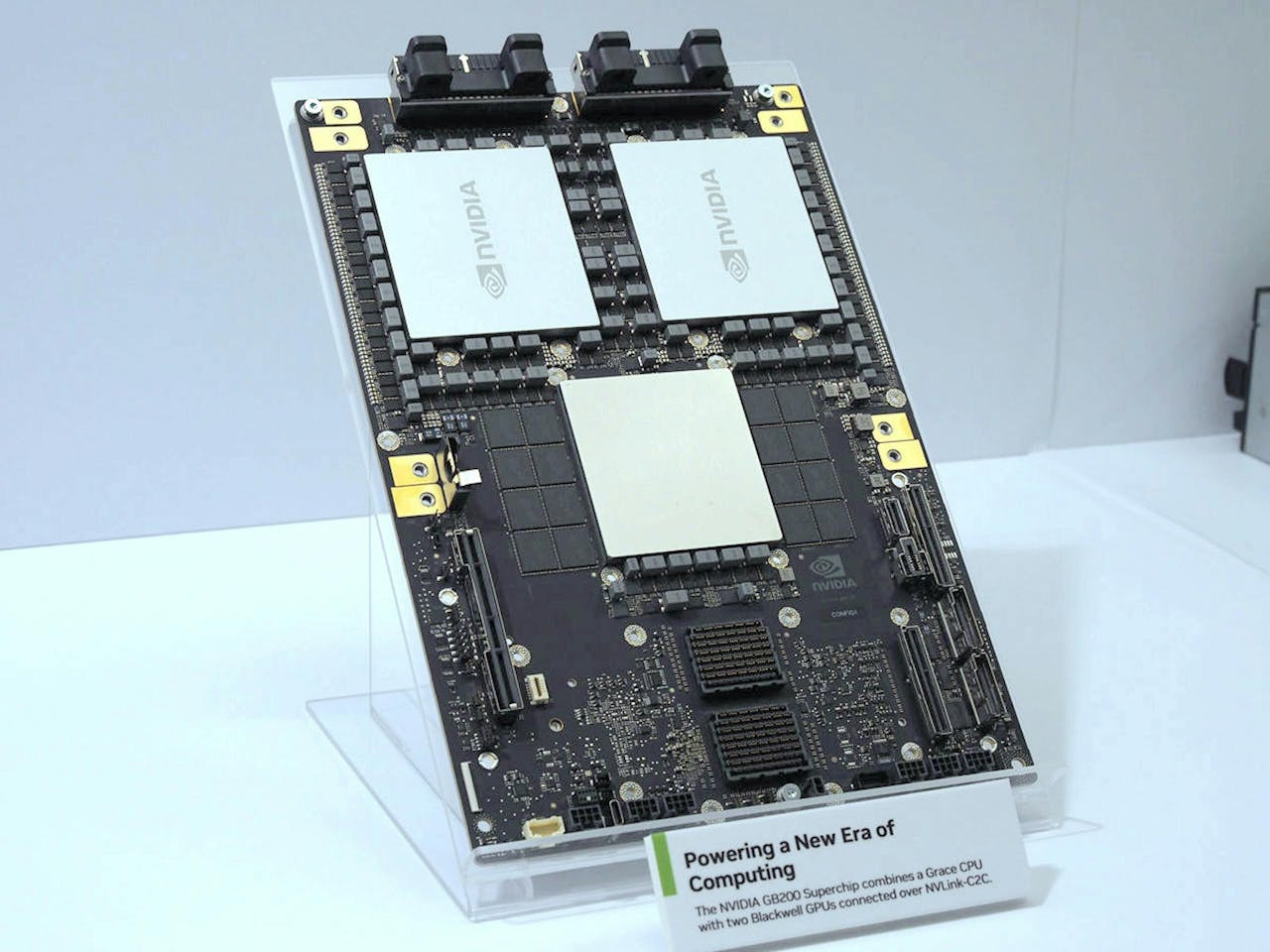

NVIDIA在2024年3月的GTC大會公布全新架構的Blackwell加速器,隨著Blackwell步入量產急將出貨,Blackwell首次於MLPerf Inference v4.1基準測試活動亮相,並在所有資料中心測試項目刷新紀錄,其中於處理MLPerf最大LLM工作量的Llama 2 70B,相較NVDIA H100 Tensor Core GPU高出4倍。 ▲Blackwell首次測試的成績相當亮眼 雖然Blackwell仗著新架構刷新各項紀錄,然而基於Hopper架構的NVIDIA H200 Tensor Core GPU也在此輪的於MLPerf Inference基準測試有亮眼的

11 個月前