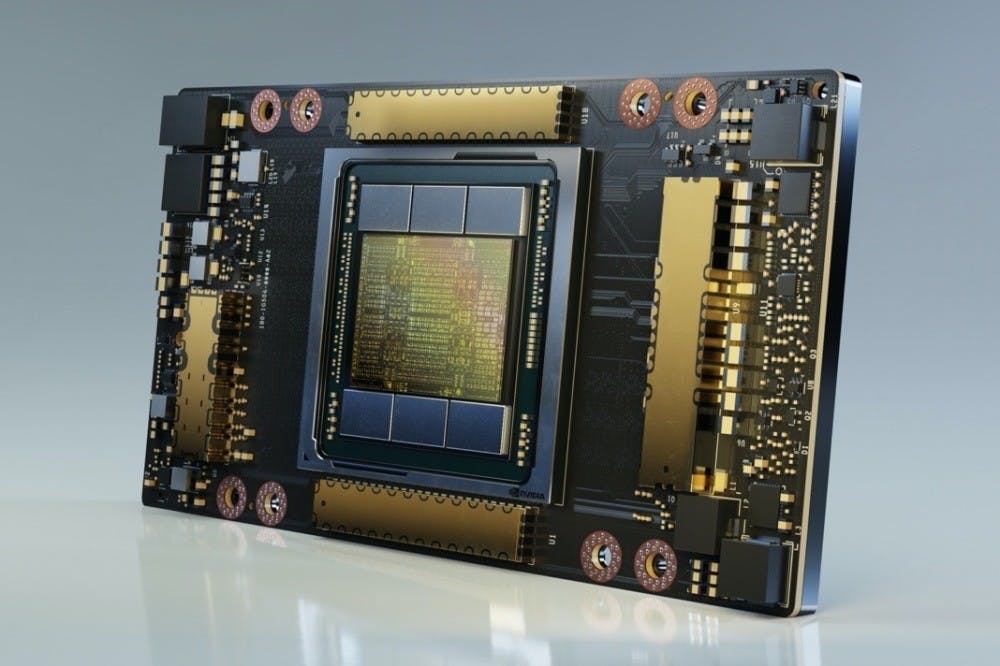

NVIDIA Blackwell再度於MLPerf Training展現壓倒性性能,強調也是唯一提交所有V5.0測試項的平台

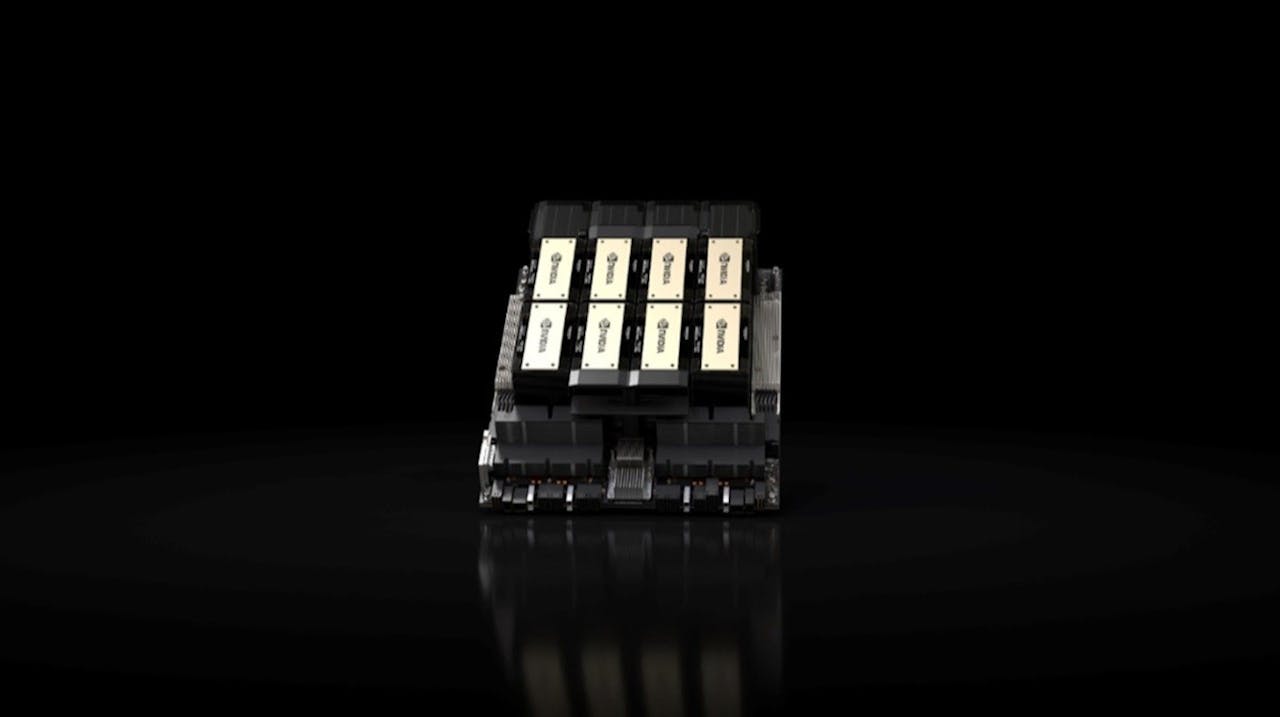

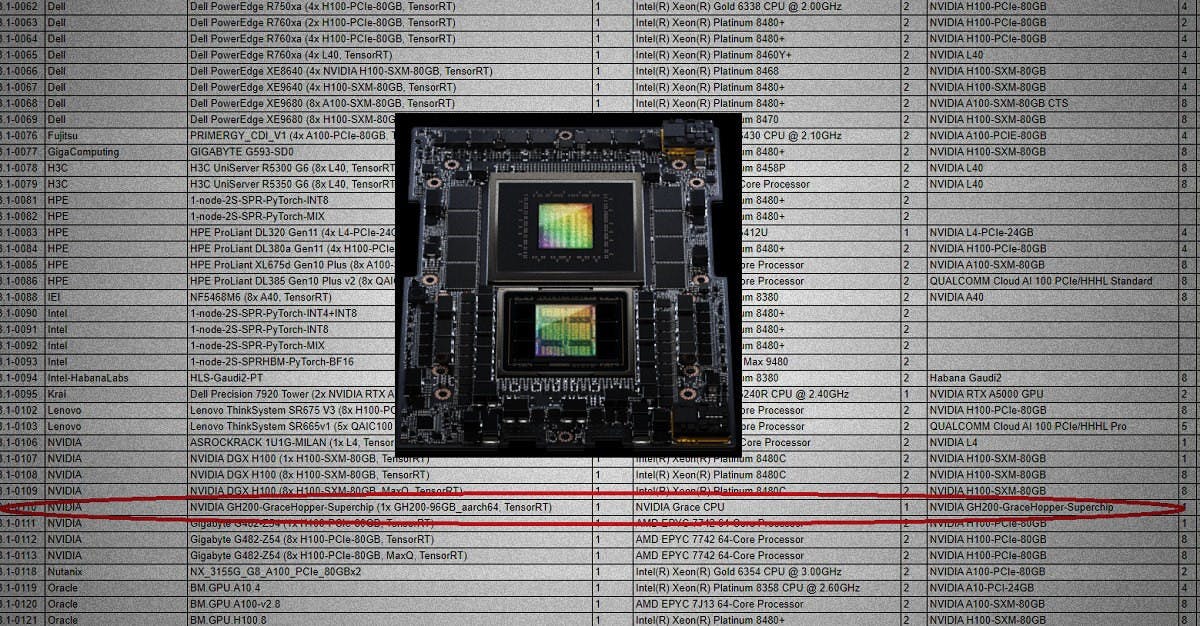

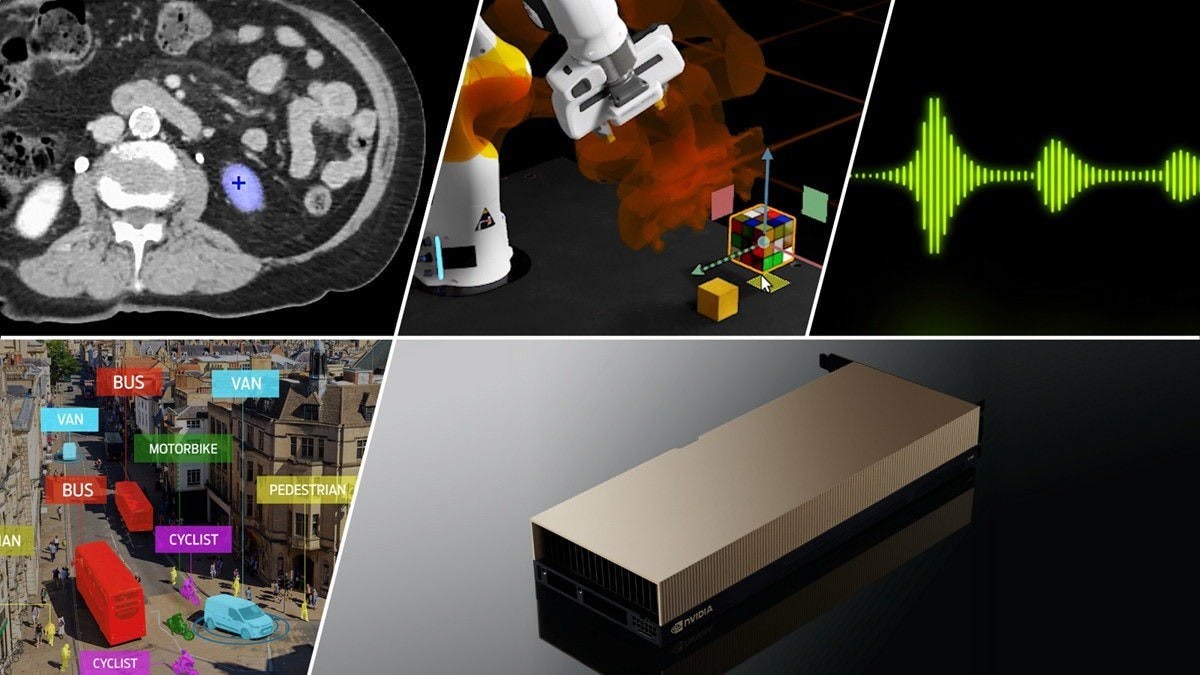

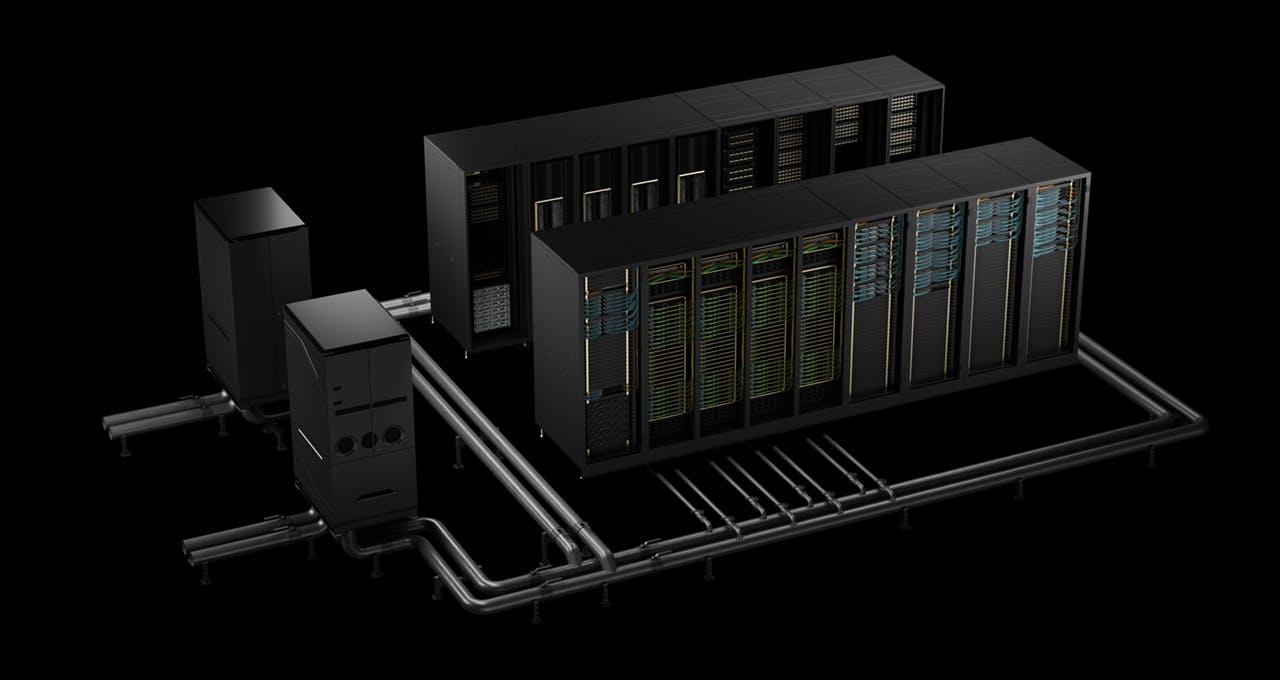

隨著基於NVIDIA Blackwell架構的系統陸續上線,NVIDIA與合作夥伴再度於新一輪的MLPerf提交測試結果,並呈現全面且壓倒性的領先優勢,這也是自2018年MLPerf基準測試推出後的第12輪測試,而NVIDIA在每一輪皆繳出最大規模效能,此次也實現在最新一版MLPerf v5.0基準測試繳交所有測試成果、包括Llama 3.1 405B預訓練的所有成果,是唯一提交所有MLPerf v5.0基準測試結果的平台,展現在大型語言模型、推薦系統、多模態大型語言模型、物體偵測與圖神經網路(GNN)的全面性。 ▲NVIDIA也繳交基於x86平台的DGX B200測試結果 NVIDIA此次大

1 個月前