Google Cloud 推出 Cloud Run GPU 服務 可彈性配置 NVIDIA L4 GPU

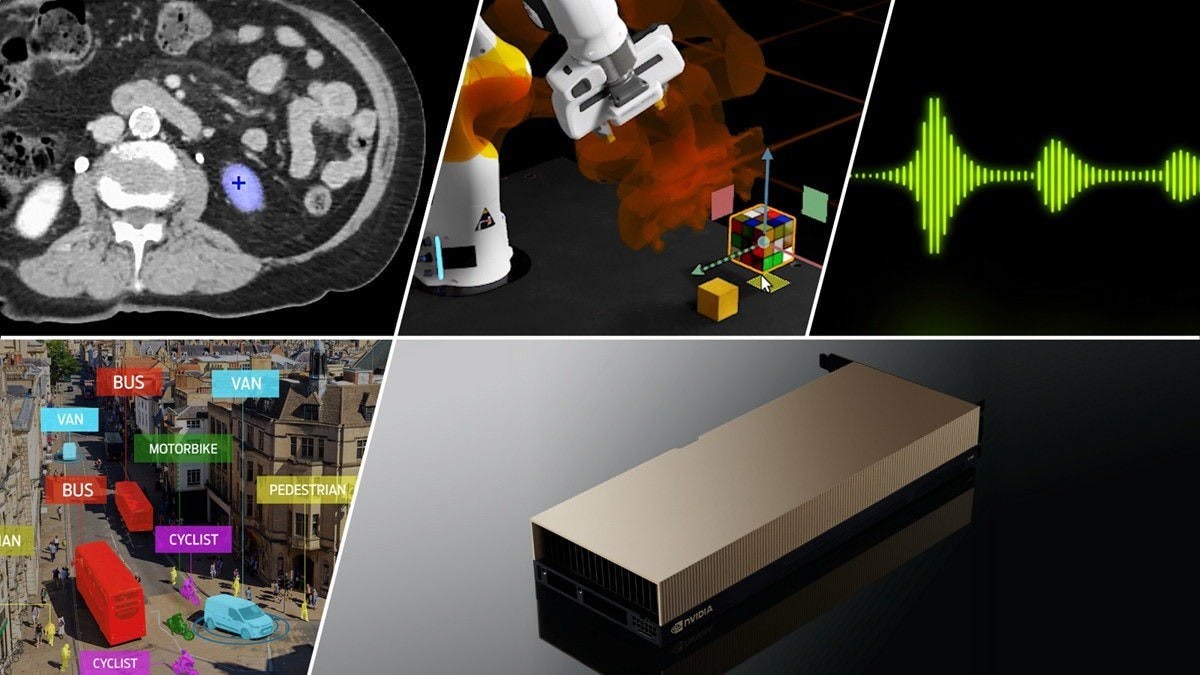

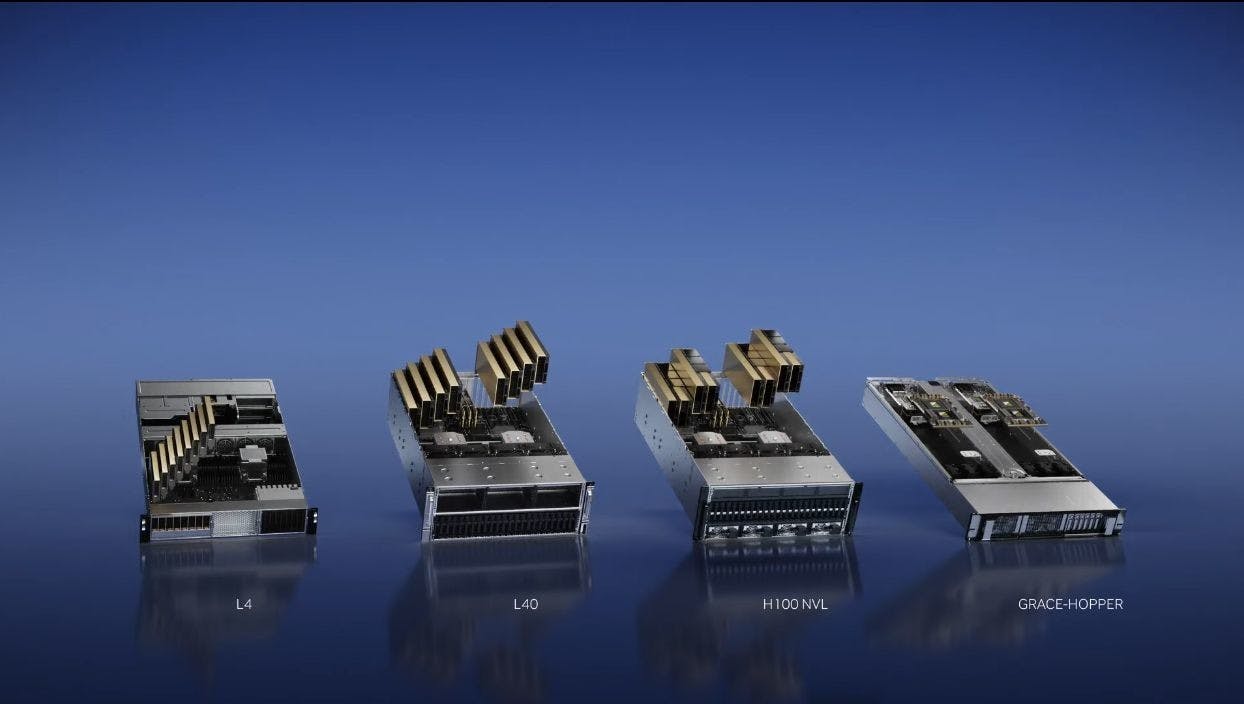

Google Cloud 推出 Cloud Run GPU,可靈活配置 NVIDIA L4 GPU,強化 AI 應用與雲端運算效率。 Google Cloud稍早宣布推出Cloud Run GPU服務,讓使用者能透過此服務以於雲端形式使用NVIDIA L4 GPU,藉由自動擴展、彈性佈署形式使用,主要針對人工智慧運算、推論訓練等工作負載使用。 同時,由於無須事先申請設定GPU配置規模,可自動依照運算需求彈性配置GPU數量,因此不會造成GPU在未使用時造成資源閒置,進而產生額外成本,藉此增加佈署彈性,更可藉由自動化佈署簡化管理難度。 此服務採以秒計費形式使用,同時在不使用時即可自動歸零,同時在冷

1 個月前