ARM 發表 SME2 延伸指令集,加快 Android 裝置 AI 應用開發,優化終端運算效率。

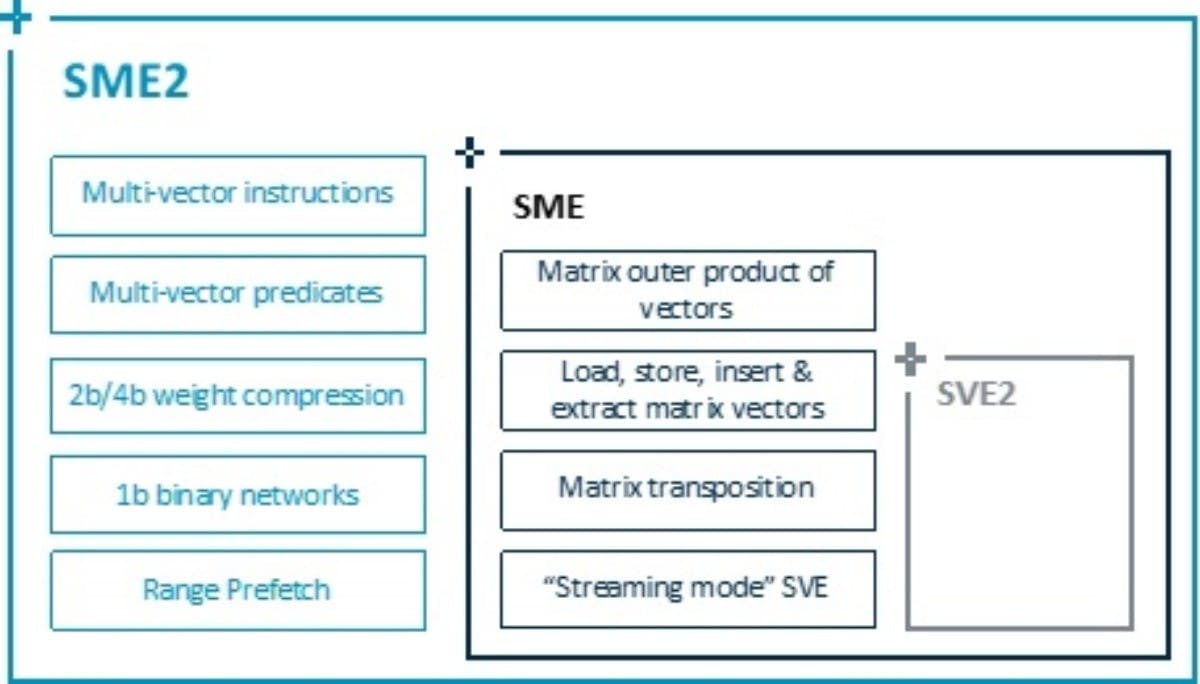

隨著裝置端AI應用加速普及,從拍照、語音、影像處理到與AI助理的互動需求日益複雜,Arm宣布以其可擴展矩陣延伸指令集2 (Scalable Matrix Extension 2,SME2),強化其運算平台在行動裝置中的AI運算能力,藉此協助開發者在無須額外修改原始碼的情況下,即可提升AI應用效能,並且達成低功耗與高效率的應用體驗。

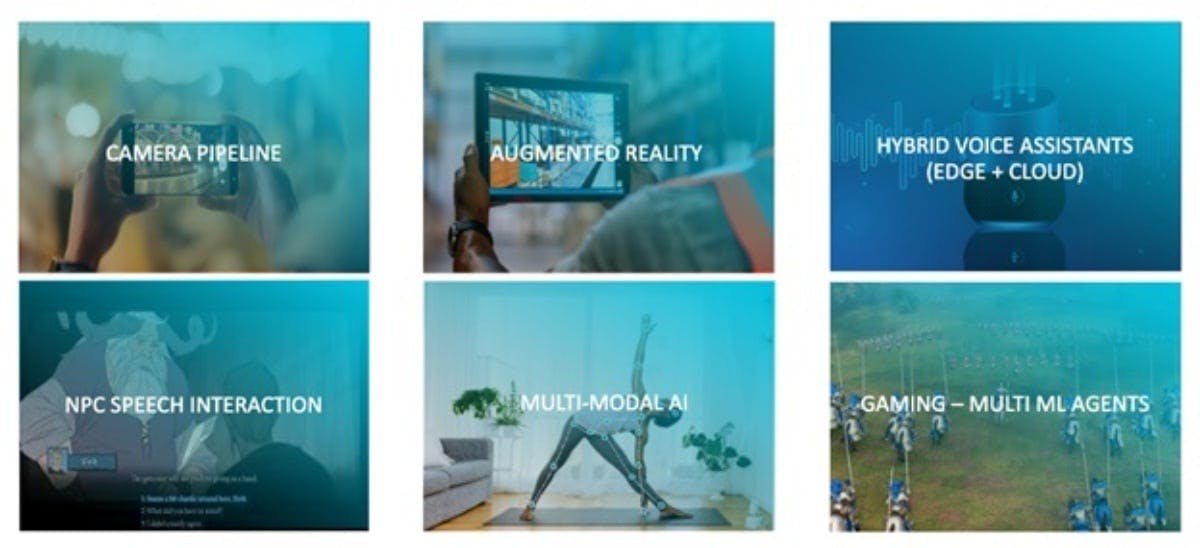

SME2為Armv9指令集架構中的高效能CPU指令集升級,專為加速電腦視覺、語音辨識、自然語言處理等AI工作負載處理效率所設計,可直接運行於行動裝置CPU上,無需額外仰賴雲端運算資源,即可改善裝置端AI應用延遲與能耗的瓶頸。

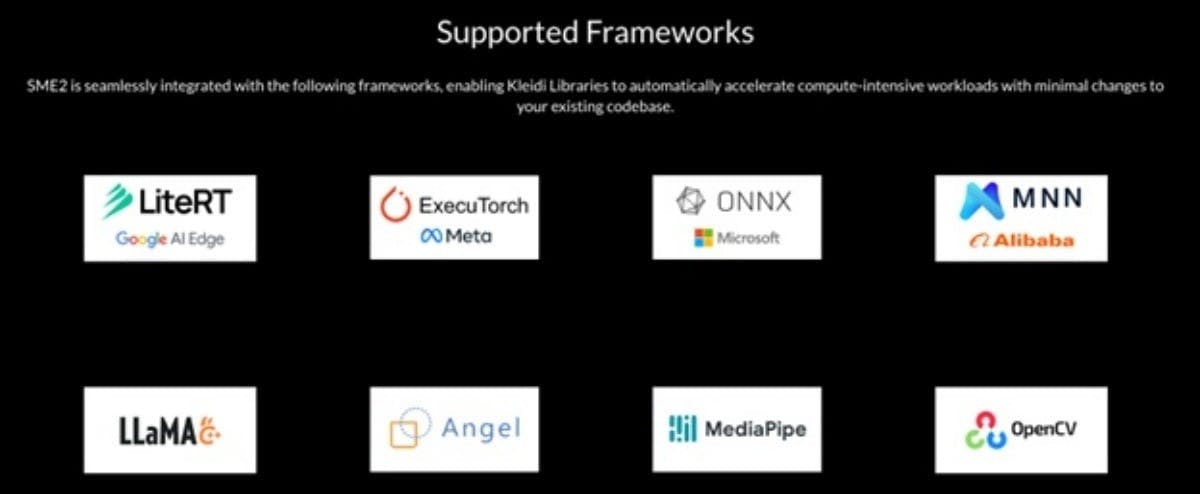

更重要的是,透過Arm旗下的KleidiAI軟體加速層,開發者無需修改模型或應用程式,即可自動藉由SME2提高的執行效能。目前,SME2已經整合進多個主流AI框架與函式庫,包括Google的XNNPACK、LiteRT、MediaPipe,或是阿里巴巴的MNN、Microsoft ONNX Runtime,甚至到llama.cpp,意味SME2已經全面融入現有Android AI軟體堆疊,確保開發者能在現有架構中即時受惠。

Google Android資深工程師 Iliyan Malchev表示,借助SME2技術,可讓Gemma 3這類先進語言模型不再需要倚賴雲端運算,就能在本地裝置上順暢運作。在同款硬體比較下,啟用SME2的Gemma 3模型在文字摘要任務中反應速度快上6倍,甚至只需1組CPU核心即可生成長達800字的內容,凸顯SME2對行動AI效能帶來的實質提升。

目前搭載SME2的Android裝置即將上市,iOS裝置中也已經有機種支援SME2指令集架構。配合KleidiAI自動導向矩陣運算的特性,開發者只要提前建構在支援平台上,即可無痛升級至新一代AI應用表現,為使用者提供更即時、低延遲與高效能的互動體驗。

根據Arm統計,目前已有超過900萬種應用服務運行於Arm架構運算平台之上,同時也有超過2200萬名開發者投入相關建構工作。隨著SME2技術普及,未來將有更多應用可在行動裝置上實現複雜AI運算,徹底翻轉使用者的行動體驗與效能期待。