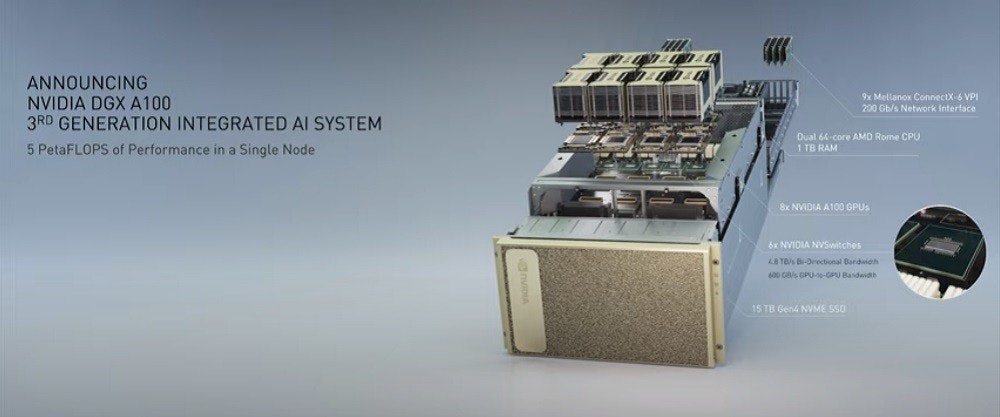

NVIDIA 在發表 Ampere 架構的 NVIDIA A100 通用運算處理器之際,也宣布新一代的 DGX A100 系統,這也是 NVIDIA 第三世代的 DGX 系統,除了具備高達 10 petaflops 的運算性能外,也具備高達 5 petaflops 的 AI 性能;而美國能源局的阿貢國家實驗室宣布率先採用 DGX A100 ,並將活用其 AI 與運算力藉此對抗與分析武漢肺炎。

單一套 DGX A100 的系統起始價格為 199,000 美金,目前已經開始透過 NVIDIA 合作夥伴網路銷售,包括 DDN Storage,Dell Technologies,IBM,NetApp,Pure Storage 和 Vast 等儲存設備供應商也計畫將 NVIDIA DGX A100 整合到其產品內,包括採用 NVIDIA DGX POD 與 DGX SuperPOD 的參考架構產品。

▲每套 DGX A100 連接 8 顆 GPU ,提供高達 320GB 之 HBM2 RAM

DGX A100 採用 8 個 NVIDIA A100 GPU ,透過第三代 NVLink 搭配 6 組 NVSwitch ,實現 8 GPU 高速連接,透過每個 GPU 共 12 路 NVLink ,實現 GPU 與 GPU 之間高達 600GBps 的頻寬,並串聯 8 顆 GPU 資源,提供高達 320GB 頻寬達12.4TB 的 HBM2 RAM ,能夠處理超大規模的數據或 AI 模型訓練。

▲ NVSwitch 仍在多 GPU 資料傳輸扮演重要腳色

此外,透過 NVIDIA A100 的 MIG 多執行個體 GPU 技術,可將一套 DGX A100 切割為 56 個執行個體進行多工,因應多個較小的工作負載提供更好的運算性能,但同時亦可由 NVLink 使 8 顆 GPU 之間相互串聯,達到驚人的 10 Petaflops Int 8 算力,以分割與合併,提供企業因應不同工作負載的彈性應用。

▲透過 Mellanox 技術使多個系統能高速連接提升性能

DGX A100 同時搭載 9 路 NVIDIA Mellanox HDR 200Gbps 高速互聯網路,可提供跨系統之雙向每秒 3.6TB 頻寬,藉由如 RDMA 、 GPU Direct 與來自 Scalable Hierarchical Aggregation and Reduction Protocol ( SHARP )等 NVIDIA Mellanox 的網路內運算與網路加速引擎,此外也支援 NVIDIA DGX 軟體堆疊,可針對 AI 與數據科學軟體之工作負載提供最佳化。

▲當前資料中心所需的規模與功率

▲一套具備 5 組 DGX A100 的機櫃即有驚人的性能

NVIDIA 強調,由 5 個 DGX A100 構成的機架系統,除了提供高達 25 petaflops 的性能,足以與大型 AI 訓練與推論訓練中心相同,僅需要 1/20 的功率、 1/25 的空間,而成本亦僅有 1/10 ,並以單一系統同時滿足資料分析、通用運算與 AI 三大需求。

▲ NVIDIA 此次亦在內部以三個月時間架構全新的 DGX SuperPOD

此外, NVIDIA 亦藉由 DGX A100 架構新一代超級電腦系統 DGX SuperPOD ,藉由高達 140 個 DGX A100 構成叢集,實現高達 700 petaflops 的 AI 。 NVIDIA 透過 NVIDIA Mellanox HDR 200Gbps InfiniBand 將 140 套 DGX A100 系統相互連接,未來將用於包括對話 AI 、基因組學與自動駕駛等內部研究使用,藉由模組化架構,僅在三周就完成架設。

同時, NVIDIA 也提供基於 DGX A100 之新世代 DGX SuperPOD 參考設計,提供客戶用於建構基於 DGX A100 的超級電腦系統的藍圖,使客戶能以幾個月的時間完成建構基於 DGX A100 的超級電腦系統,並簡化系統規劃的程序。

NVIDIA 也將針對 DGX 平台推出 NVIDIA DGXpert 計畫, NVIDIA DGXpert 計畫使 DGX 的客戶能與 NVIDIA 的 AI 專家會面與提供 NVIDIA DGX-Ready 軟體,透過 AI 專家協助客戶導入認證的 AI 企業級軟體,自 AI 部署、規劃、實作到持續最佳化,使客戶能夠順利建構與維護先進的 AI 設備。