這一兩年PC產業最火熱的名詞之一莫過於「AI PC」,其影響之劇烈就連善於重新包裝行銷的蘋果也變相使用縮寫為AI的Apple Intelligence加入戰局,同時微軟也宣布將AI PC加以狹義化的「Copilot+ PC」計畫,長年載浮載沉的高通Windows on Snapdragon計畫則乘著微軟的這波操作大喊The PC Reborn,而不涉及CPU的NVIDIA也宣稱載有RTX獨立顯示卡的電腦都是AI PC,現在新一代電腦;作為一位參與過超過10年COMPUTEX的媒體工作者,筆者想透過自己的理解來談論這股AI PC浪潮(其實同樣的道理也可套用在AI手機啦)。

甚麼是AI PC,若廣義解釋很難有不具AI的PC

自古以來PC產業許多的熱議名詞都是透過包裝與行銷的方式賦予定義,如Intel的Centrino就是將其下CPU結合Wi-Fi無線網卡的品牌,也是使這個不具意義的單詞成為當年最夯的筆記型電腦所必備的標籤;所以如果從客觀的角度,無論是產業稱之的AI PC,微軟的Copilot+ PC或是蘋果的Apple Intelligence,都是經過重新包裝且被賦予特定狹義的行銷名詞。

回到所謂的AI,指的是Artificial Intelligence,也就是俗稱的人工智慧, 是一種透過電腦程式的仿生技術,其起源甚至可追溯到上個世紀的1940年代的電腦計算機,不過在1997年IBM的深藍系統推出後沉寂相當長一段時間,甚至也被視為AI發展可能就會停滯在一個階段;然而這些初期的AI技術已經常見於日常生活領域,小至冷氣機的微電腦控制,或是遊戲中的NPC等,現在看起來陽春甚至一般人嗤之以鼻的功能,都是廣義解釋之下AI的應用。

也就是以廣義的方式,目前任何一台電腦都足以稱為AI PC,畢竟即使是現在最入門的一款電腦,運算性能早就足以超越深藍,且也別忘了2006年Sony PlayStation 3所使用的Cell架構處理器甚至性能高到在當年被視為足以用於軍事用途而無法在特定地區銷售;只是這種過度廣泛的AI功能畢竟過於日常,根本不會在當代被視為AI。

從機器學習到生成式AI才是當前用於形容AI PC的基礎

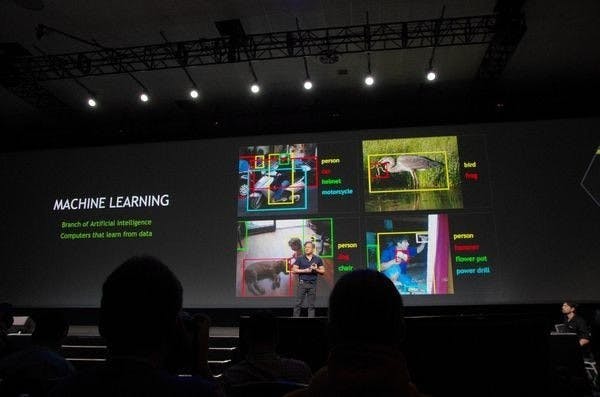

那麼現在被重新定義為AI PC的新一代個人電腦又是甚麼?就要談到近10年AI歷經兩度的顛覆性發展,一者是又已經進入一定的成熟期、在手機功能大量被融入、日常到幾乎被遺忘的機器學習(機器學習),另一個則是現在AI PC(同時還有AI手機)奉為圭臬的生成式AI技術;雖然現在多個品牌都把酷炫且具更多未來性的生成式AI作為AI PC的主打,但實際上現階段更多AI PC的功能是以機器學習為基礎的應用。

機器學習是建構在90年代由法國科學家楊立昆提出的積捲神經網路的基礎,然而在上個世紀的電腦運算是建立在CPU為尊的概念,但執行積捲神經網路需透過大量的核心執行,是故積捲神經網路雖然在當時展現出色的突破,不過也受限當時的運算性能與電腦架構,始終未能有突破性的表現;直到2012年科學家Alex Krizhevsky透過基於GPU的CUDA加速運算結合機器學習的AlexNet在機器圖像辨識挑戰ImageNet達到突破性成果後,AI產業再度受到重視。

當前使用者在許多裝置上看到強調結合AI的應用都是與機器學習息息相關,尤其在手機上更是顯著,舉凡手機相機的智慧物件與場景辨識、圖像畫質增強,或是依據使用者作息與裝置習慣的智慧充電,還有語音辨識與語音轉文字的結合等,皆是不同規模的機器學習應用;然而機器學習雖為沉寂近20年的AI一詞帶來又一次的高峰,不過很快就受到應用領域受限於以文字、數據、圖像為主的功能,生成式AI在話題性又稍稍的熄火。

為現在AI PC話題奠定基礎的關鍵,即是由OpenAI引領、以大型語言模型為基礎的生成式AI技術,當然投入生成式AI技術且有出色成果的廠商不僅限於OpenAI,不過由於OpenAI率先將其ChatGPT開放且商用化,使大眾得以一親芳澤,也由於生成式AI將AI從尋找問題解答昇華到能夠產生符合原則的結果,使AI首度具備創造力,加上許多名人利用生成式AI產生各式的圖像(無論好壞,那個把生成式AI產生的圖像當自己畫的圖的AI教母就不用多說了)引發社會熱議。

以NVIDIA DLSS 3技術解釋機器學習與生成式AI的差異

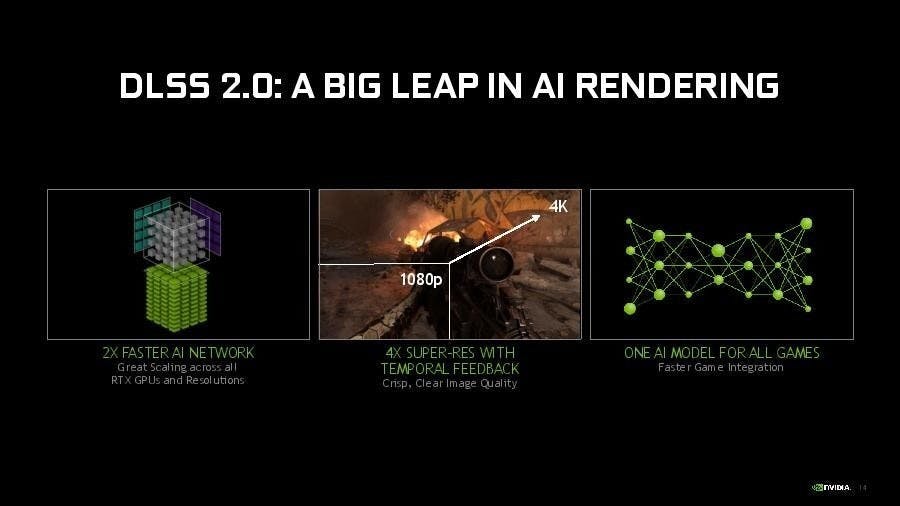

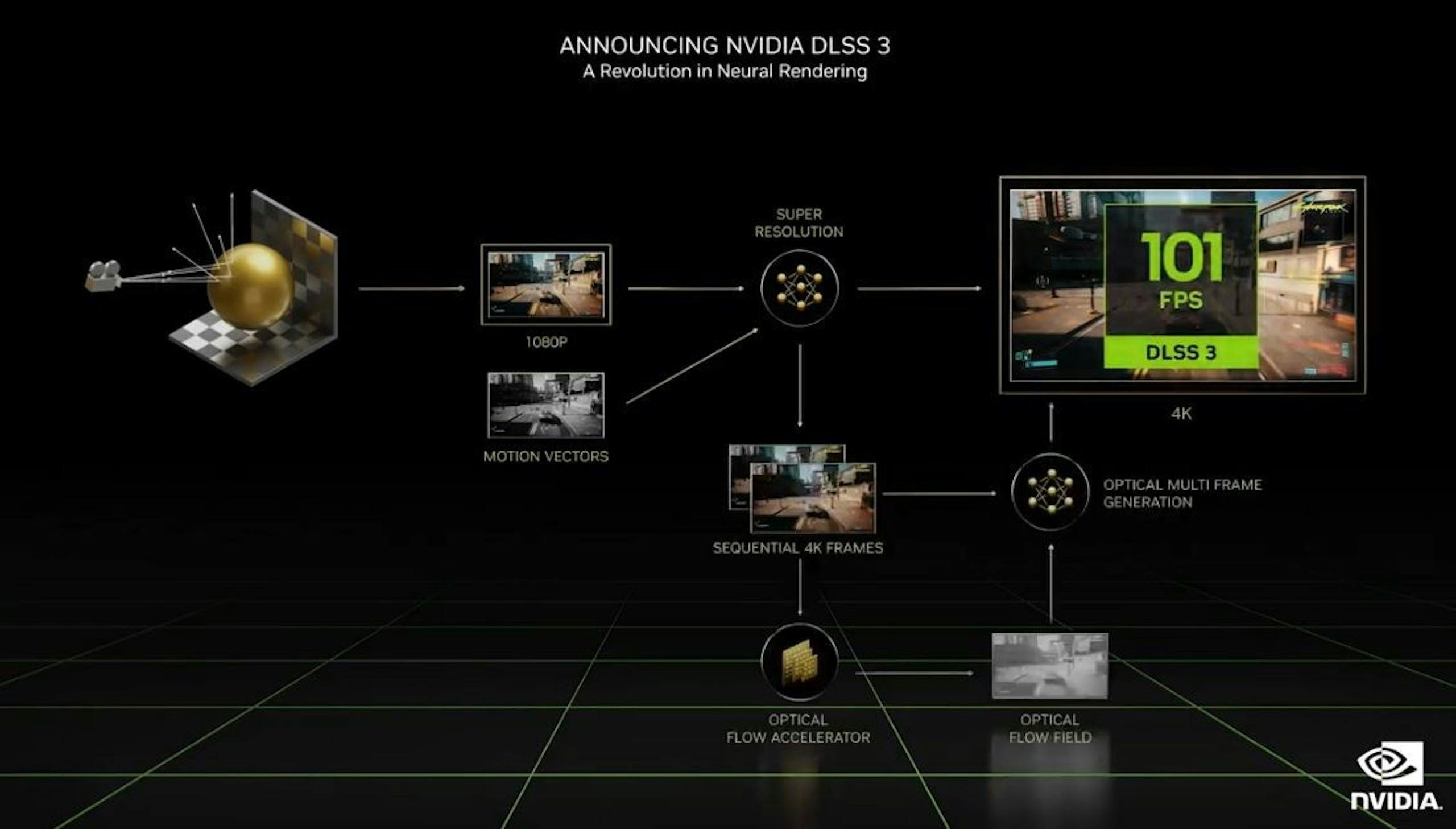

畢竟筆者接觸引領AI硬體的NVIDIA已有超過10年的時間,筆者認為容易作為解釋機器學習與生成式AI差異的差異的技術莫過於NVIDIA在遊戲娛樂所提供的DLSS 3技術;DLSS 3是目前NVIDIA最新版本的遊戲圖像增強技術,也剛好是將原本DLSS 2以前以機器學習為基礎的功能,加上基於生成式AI的畫格生成(Frame Generation)的技術結合。

初始的DLSS是NVIDIA活用機器學習的功能,透過學習大量的高解析度遊戲影像產生的AI模型,使RTX GPU的Tensor Core以機器學習模型將低解析度的畫質進行增強;不同於傳統圖像升頻只能依據固定的方式填補解析度提高後的畫質差異,DLSS更像是讓AI臨摹高解析度圖像的細節,把原本低解析度的圖像描上幾乎等同於原生畫質的細節;有點像是看著一面整牆輸出的高畫質海報,將手邊明信片臨摹到成一張高品質的海報。

不過直至DLSS 2以前的技術都是將低解析度的畫格提升到更高的解析度,假設顯示卡在720P解析度畫質能夠產生60fps的幀率,DLSS最多也只是將解析度提高到4K,但不會超過顯示卡在低解析度的最高幀率,換言之在DLSS 2之前的畫質到幀率優先模式是取決在作為基礎的解析度差異;但DLSS 3的增強技術Frame Generation畫格生成則是透過生成式AI的無中生有的技術。

Frame Generation並非早期的補幀技術,在Frame Generation前的補幀技術是在幀與幀之間插入一幀黑畫面,意味著幀與幀之間並不連貫;但Frame Generation是透過分析與預測前後幀的關係,透過符合前後幀變化的原則,在幀與幀之間加入連貫的一幀,而這一幀自始自終都非透過GPU遊戲圖像運算產生,而是由RTX GPU內的Tensor Core運算、GPU從無到有描繪的一幀。

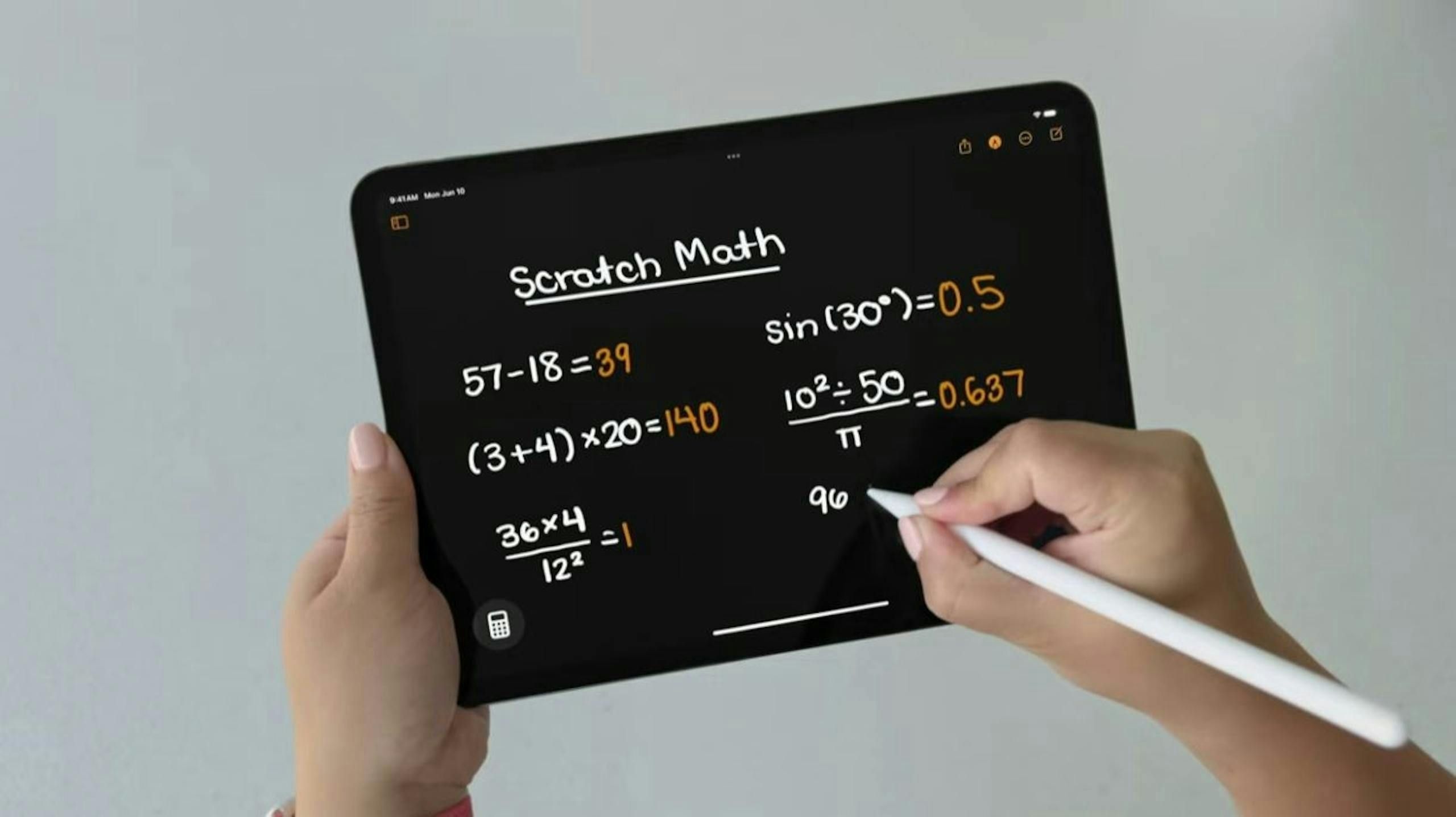

機器學習的目的是能夠在符合賦予的原理之下探索問題的解答,但其機制仍無法擺脫找尋答案,適合處理不需創意的內容,像是圖像增強、語音轉文字或是自大量未彙整的資料找尋符合描述的一類應用,例如蘋果發表會iPad OS的Smart Script原則上就是學習用戶書寫習慣進行分辨與臨摹的機器學習;而生成式AI則是能夠在給予描述與問題後,遵循一定的原則從無到有產生,像是目前熱門的圖像生成或是ChatGPT一類可模擬人類不同語氣回答的技術。

Windows生態系一個AI PC、N種解釋

在2023年時,AMD與Intel紛紛先喊出AI PC的概念並推出對應的處理器,不過回過頭檢視當時的AI PC,更像是一段黑歷史,因為當時AI PC的功能除了多了一顆可以呼叫微軟Copilot的按鍵以外並無太多有感功能,當時強調透過NPU可以進行視訊圖像增強、收音強化等應用,實際上早在智慧手機相當成熟,而在PC上亦可透過NVIDIA的RTX Studio執行。

在2024年5月,可說是微軟開始收割AI PC的一大步;微軟攜手被其Windows on Arm所困超過10年的苦主高通登高一呼公布Copilot+ PC計畫,強調透過新一代搭載NPU的CPU處理器可在裝置端執行一定程度的Copilot功能,高通的Snapdragon X Elite則是首波Copilot+ PC所採用的處理器,同時AMD、Intel也同步宣布將緊接在後推出符合Copilot+ PC認證、超過40TOPS AI性能NPU的下一代處理器。不過從筆者的認知,所謂的Copilot+ PC只是微軟另一種設下繁複限制的認證計畫,旨在不影響原本裝置續航力為前提提供AI功能。

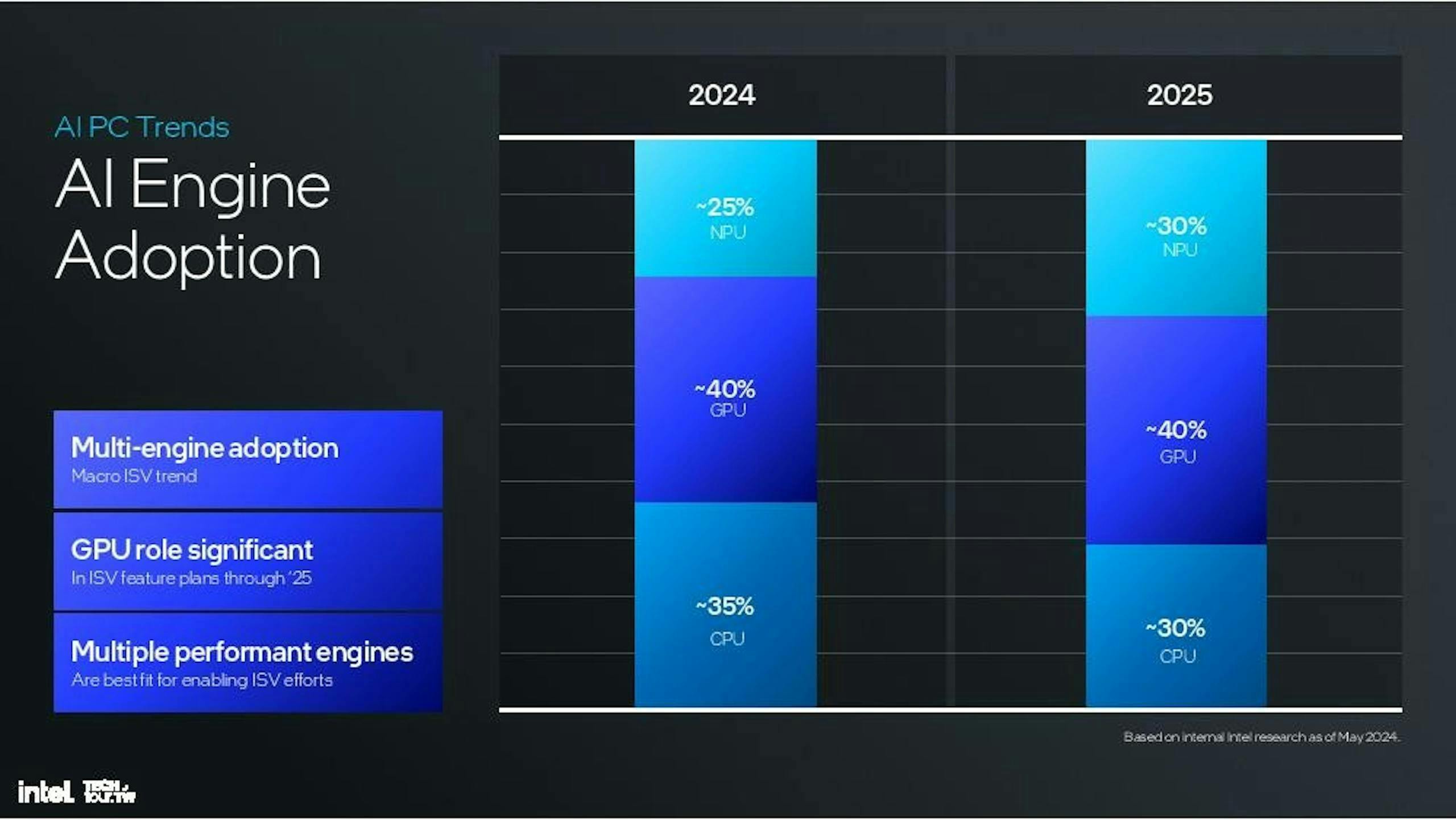

若熟知當前生成式AI技術的基礎,目前最大型的生成式AI模型多是由基於NVIDIA加速運算的AI超級電腦所產生,同時早在幾年前搭載獨立顯示卡的PC與筆電就足以執行生成式AI應用之一的圖像生成;那麼微軟為何會強調Copilot+ PC需具NPU算力?主要就是因為在目前的大型語言模型技術之下,專為執行特定AI任務的NPU能使用比CPU、GPU更具能耗效率的方式執行新一代AI應用。

這裡又會延伸另一個問題,所以搭載NVIDIA RTX GPU的系統不能稱為AI PC嗎?實際上只不過是GPU不在微軟Copilot+ PC的定義範疇,而且RTX GPU早已不僅只是GPU,其架構設計也早已融入NPU;若回顧NVIDIA RTX架構的發展,早於代號Turing的GeForce RTX 20系列顯示卡就在架構加入稱為Tensor Core的AI加速架構,Tensor Core的任務實際上就與NPU相同,皆是針對特定AI負載加速的專屬加速核心。

那為什麼微軟的Copilot+ PC只將CPU具備40 TOPS AI算力NPU、以及系統須具備16GB RAM列入要求,即是因為微軟在定義Copilot+ PC的前提就是需要在邊際端高效率的執行部分Copilot任務,然而若這些任務需要在GPU執行時,首先是會導致設備需要搭配獨立顯示卡,其次是由於Tensor Core是融入在GPU架構內,執行時需喚醒GPU,即便是執行不複雜的任務也會影響能耗(可以比較RTX VSR影片增強使用前後的能耗增加)。

微軟之所以設定40 TOPS AI算力與16GB記憶體的門檻,大致上筆者可以推測是呼應屆時微軟Windows的Copilot+ PC的模型執行所需,當然AI算力是越高越好,不過考慮到半導體技術、執行的模型複雜度、運算的時間等,40 TOPS是微軟認為屆時在裝置端執行Copilot AI模型所具備的最低限度的算力。

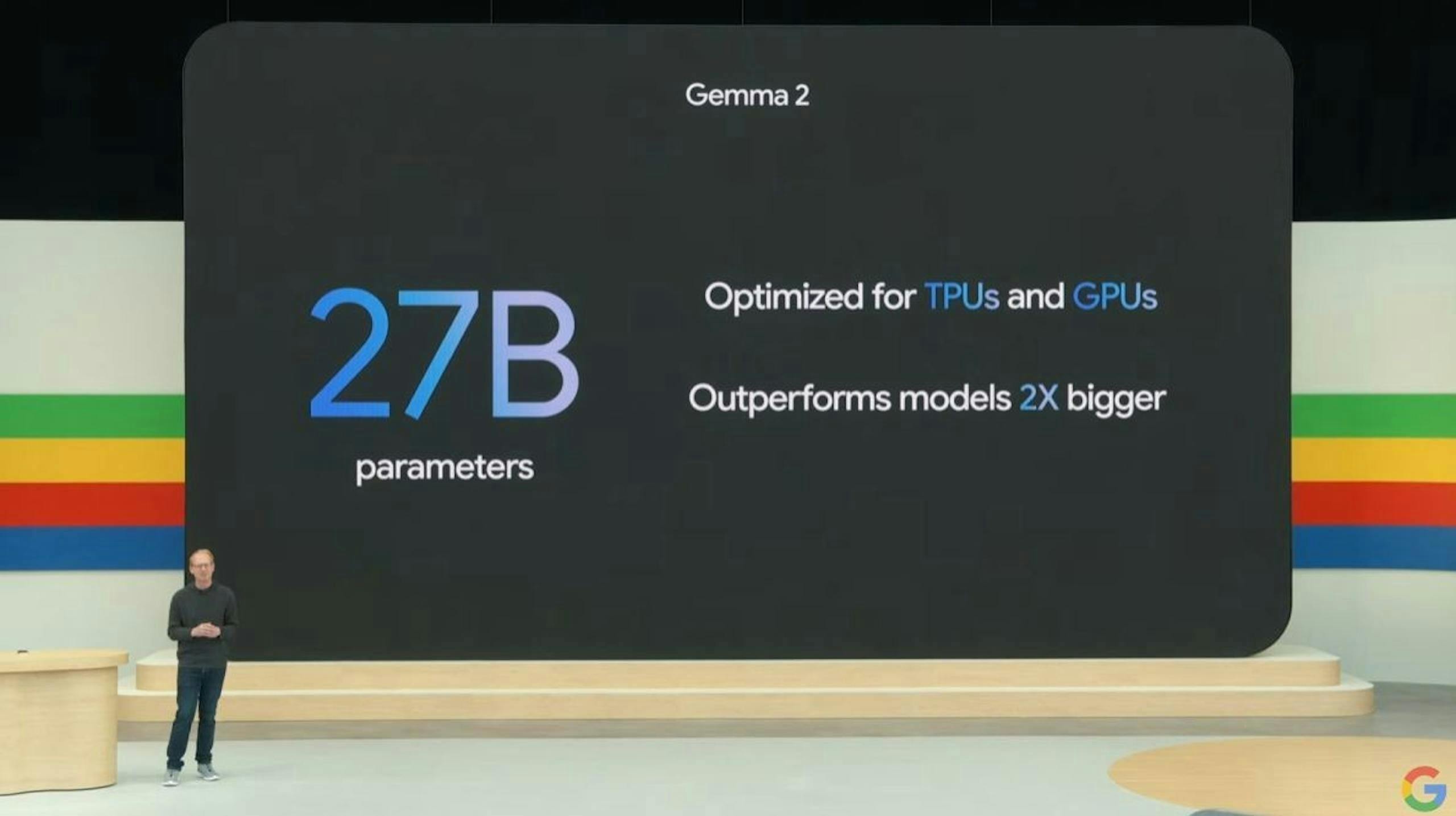

記憶體大小則是決定可執行的模型大小,會設定16GB容量是因為系統還要保留執行其它多工任務所需具備的空間,是故以筆者個人的武斷想法,實際上Copilot+ PC一旦執行最複雜的邊際端生成式AI負載時,也等同現行8GB RAM的Windows系統;筆者推測微軟最終可能會提供最大13B參數的Copilot模型供邊際端執行,依照壓縮技術可能會占用到最多7GB前後的RAM容量,這也是為何微軟會設定16GB做為門檻的原因。

避談AI PC但卻很聰明的把AI無縫成為系統層一部分的Apple Intelligence

蘋果在WWDC從頭到尾並未單純提及AI PC一詞,因為相較於Google手機強勢PC弱勢、微軟Windows有PC沒手機,蘋果旗下是多元型態的生態系,如果要提到AI PC還要同時提到AI手機與AI平板,然而從體驗又是回到同一個體系,所以蘋果改迂迴的使用縮寫是AI的Apple Intelligence代表其裝置端AI計畫。

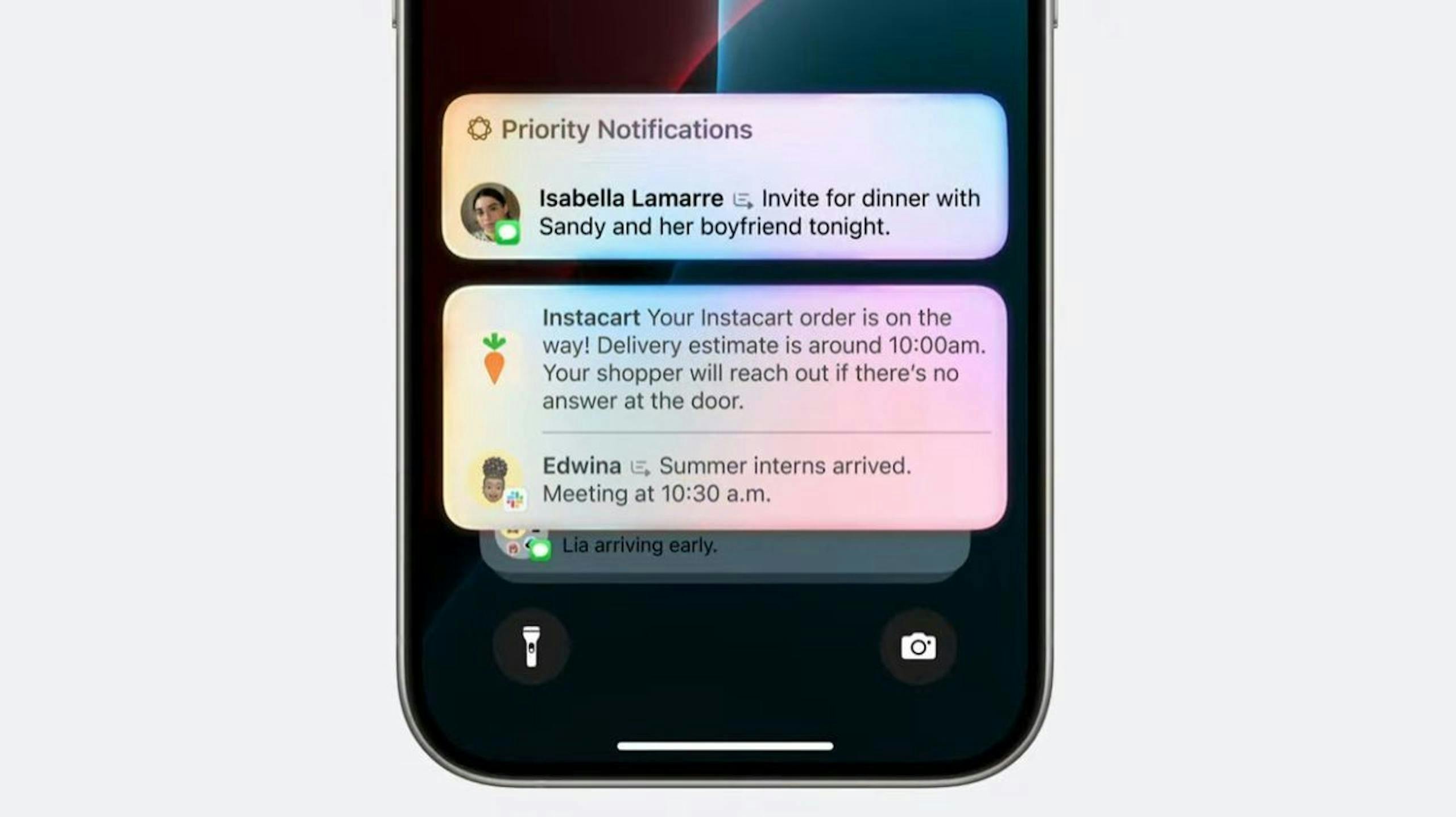

不同於Windows PC陣營晶片商只能依靠提供系統的微軟領頭,但微軟又聚焦在自身的Copilot品牌上,蘋果Apple Intelligence則是將你所能想到的AI功能無縫的融合到各種高階(對,是高階裝置,因為最低門檻至少要A17 Pro或M1晶片)的蘋果裝置,並採用部分邊際、部分雲端的混合模式,同時引入OpenAI的技術提供進階生成式AI應用。

如同集團姊妹品牌Inside所提,蘋果是用最平淡無奇的方式打這場AI大戰,所有的功能都是長期觀察AI技術都會看到的,實際上並沒有特別的過人之處,只是蘋果將這些功能通通使用Apple Intelligence包裝後,再利用蘋果最擅長的系統級整合方式使使用者以幾乎無感的方式就能活用AI。

筆者認為Google與微軟在這波AI大戰最欠缺的就是如Apple Intelligence的包裝技巧,導致消費者對於裝置所具備的AI功能仍一頭霧水;以Android為例,Google開始利用Gemini作為AI的新品牌,但Google仍未放棄Google Assistant品牌,使兩個一部份重疊的服務分別使用不同的品牌,雖然筆者可理解Gemini獲得生成式AI加持能進行更複雜的功能,而Google Assistant僅式傳統的語音助理,但像蘋果就直接釜底抽薪維持Siri品牌但底層功能早以進化。

不同於Google AI功能的混亂感,微軟則專注在經營Copilot品牌,但相較Apple Intelligence以系統級整合的方式呈現,Copilot給人的感覺較像是過往Cortana的更名,若從認知則僅如同Siri的等級;更不用說Windows系統最大的問題就是疊床架屋般的設計,在以自由性為優點的發展模式下,至今的Windows 11仍有許多過往殘存的包袱,加上許多系統功能都可找到更出色的第三方應用,筆者對於微軟能好好的為Copilot=AI PC的說故事能力仍舊質疑。

推廣邊際端AI並非為了減少服務成本,除非你願活在楚門的世界

在微軟大舉喊出Copilot+ PC的AI PC計畫時,有位分析師逆風的表示AI PC無法帶動換機潮,筆者認為這個結論確實不能說錯,但他的原因卻是AI PC的目的是在幫微軟分散伺服器負擔成本,不該將AI服務的運算成本轉嫁到消費者,這點筆者就100%不能苟同;除非你完全不需要任何機器學習與生成式AI功能,否則裝置端AI的發展絕對是不可逆的行為,為什麼?想想歐盟對於隱私權的要求,在思索個人化的AI需要的是甚麼,還有蘋果現在多次重申的個人資料加密,答案就呼之欲出了。

為什麼需要裝置端AI,一方面是能降低網路連接產生的延遲,以及透過裝置端運算即時性的處理一部分基礎的AI負載;然而筆者認為最重要的就是在不影響隱私權的前提提供個人化的AI服務,尤其是許多裝置內的內容都會牽涉到個人的資訊,諸如行事曆、重要的信件往來、各種密碼、做為科學研究的資訊、或是分析師自內線取得的爆料資料等,這些資料都具有相當的個人隱私性,並不適合公開。

筆者以蘋果Appple Intelligence的Smart Script為例,Smart Script強調可透過裝置端AI的方式學習個人使用Apple Pencil的筆跡與筆觸,倘若這些行為在雲端執行會怎樣?雖然現在許多雲運算都會強調安全防護,但仍不敢100%保證不會被攻破或出包(畢竟連Chrome瀏覽器的無痕模式都被踢爆不是真無痕了),倘若這些筆跡軌跡被雲端服務平台所學習,最後被濫用於偽造筆觸代簽各種電子文件,恐怕就是用戶所不樂見的情況。

假設筆者是那位分析師,而且已經習慣使用ChatGPT或Gemini幫忙彙整複雜的資訊,當今天收到一封由內線提供的重要爆料信,但對方文筆不好內容顛三倒四難以閱讀,如果是透過雲端服務產生摘要,很難保內容資訊、爆料人的名字等不應該曝光的資訊被收入資料庫中,一旦運氣不好剛好有其它用戶詢問相關問題時,不該曝光的資料就可能會因此流出。

雖然聽起來有點危言聳聽,但個人資料隱私向來都是目前發展AI技術不能輕忽的,也是每個使用AI技術的人應該要重視的;尤其現行在裝置端的AI應用,許多都是為了幫助使用者處理與自身相關的瑣事,自然也更容易涉及許多個人私密相關的資料,除非覺得自己做人坦蕩灑脫到包括自己的身分證字號、銀行帳戶、各式密碼、住處、每日行程等都可以攤在陽光下,否則邊際端AI是有其絕對的必要性。

但依照AI的發展模式,混合式AI則仍是主流,像是許多涉及龐大運算或需要大量記憶體的AI功能即便是高階家用電腦系統也辦不到,在不涉及隱私或是去個人識別化的前提下透過雲端服務執行仍是最具效力的方式,但後續裝置端可執行的AI複雜度與準確定也勢必會跟著增加,只是模型的規模可能暫時會停留在3B至13B之間,尤其像蘋果iPhone仍停留在6GB系統記憶體的情況,為了體驗的一致性勢必不會採用參數過大的模型,Winodws裝置端也會考慮到裝置售價的因素短時間不會使模型高於13B太多,否則也會拉高最低記憶體門檻。

AI PC是否會顛覆PC使用習慣不好說,但AI功能多半體驗過就很難回去

現在PC產業多強調AI PC將會重塑PC產業,賦予PC一個全新的進展,就筆者的觀點是筆者不清楚,但很確定不會像幾年前喊的消費級VR體驗一般的熄火,主要的原因是無論是機器學習或生成式AI都是一旦體驗過就很難想像沒有這類技術輔助的技術,同時也早已在日常各種裝置體驗發生。

先別說甚麼複雜的體驗,現在的智慧手機若直接在拍照抽離AI功能,在失去軟體定義相機的加持,手機很難拍出出色的照片,也不用說利用多幀合成技術產生的夜景合成技術消失,或者是拿掉AI降噪後在室外通話的品質會有多糟;其次是如ChatGPT進行問題與內容摘要的功能更是對於經常需要從大量文字敘述找出重點的使用者相當方便的功能,以筆者的工作情況為例,幾十年下來已經看過太多光怪離奇的新聞稿,利用生成式AI協助筆者先完成簡單的摘要也能事半功倍。

筆者認為最終現在所提的AI PC會成為現在進行式,最終新一代的PC裝置自入門到高階機都會有相近的基本AI功能,到達一個時刻後,消費者就不會在關注是否被稱為AI PC,就如同現在由於智慧手機大量普及,提到手機就會直覺地想到是智慧手機一樣;不過在到達AI PC遍地開花前,恐怕一般大眾還需要歷經被名詞行銷大戰洗禮的過程。