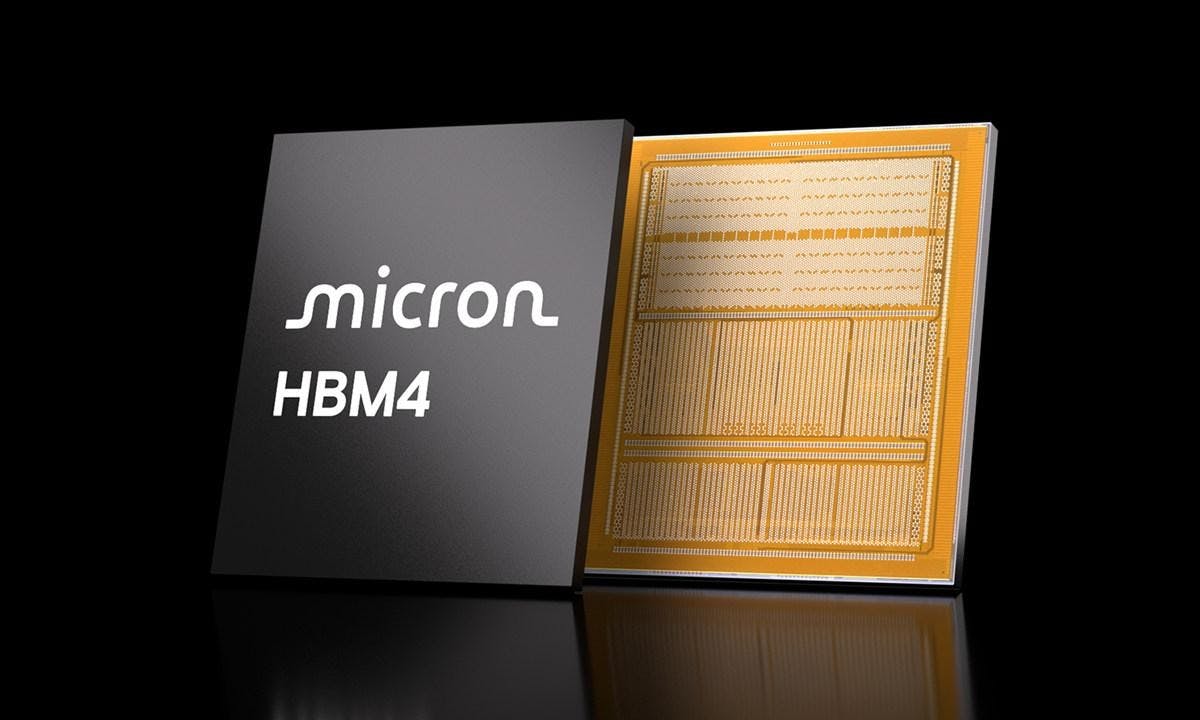

具備高吞吐量的HBM記憶體是當前HPC與AI運算不可或缺的關鍵元件之一,美光宣布已經針對多家主要客戶提供36GB 12層 HBM4的樣品,藉由更高的頻寬提升通訊與吞吐量,能夠如大型語言模型、推論推理性能進一步提升;美光強調相較HBM3E提升60%以上的頻寬,同時增強20%的能源效率。

美光預計於2026年量產HBM4記憶體,並預告將與客戶下一代AI平台量產同步

美光的HBM4記憶體基於成熟的1-beta DRAM製程,並結合12層先進封裝與記憶體自檢測(MBIST)技術提供AI平台客戶與合作夥伴所需的性能及可靠性;美光HBM4提供2,048bit介面,每個記憶體堆疊可達2.0TB/s以上的傳輸速度。

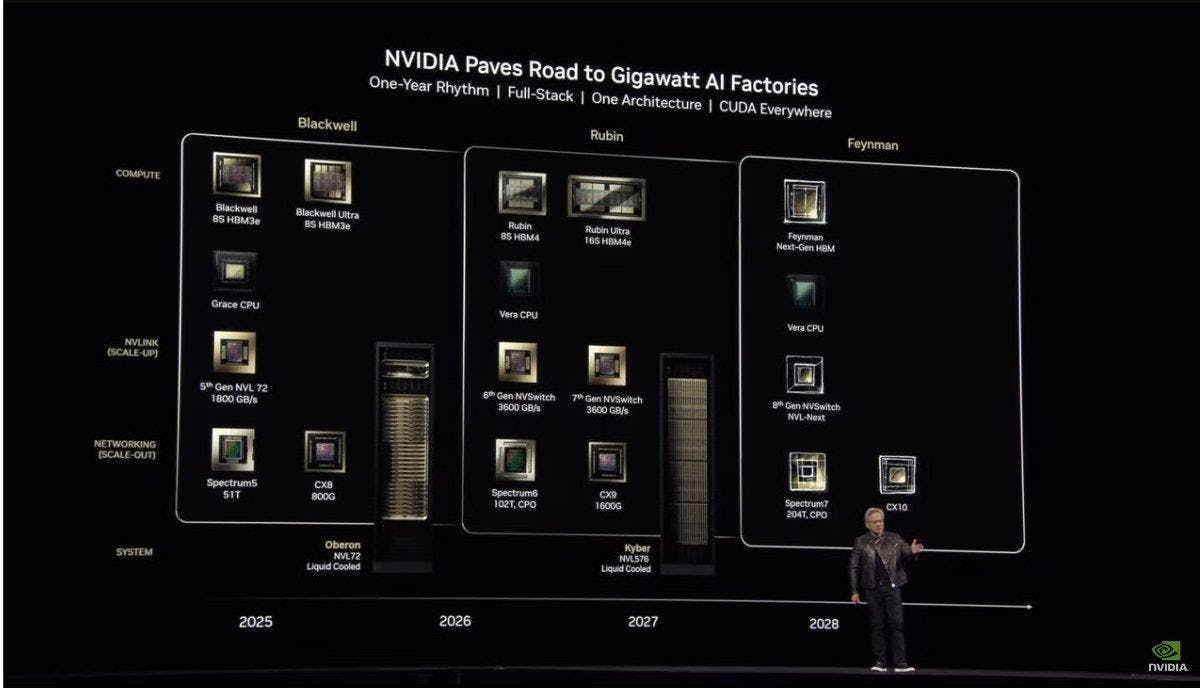

此外由於美光提到量產時間將與客戶平台同步,可預期將會配合NVIDIA預定在2026年所公布的Rubin GPU一起量產,搶攻Rubin初期量產搭配的HBM 4記憶體。