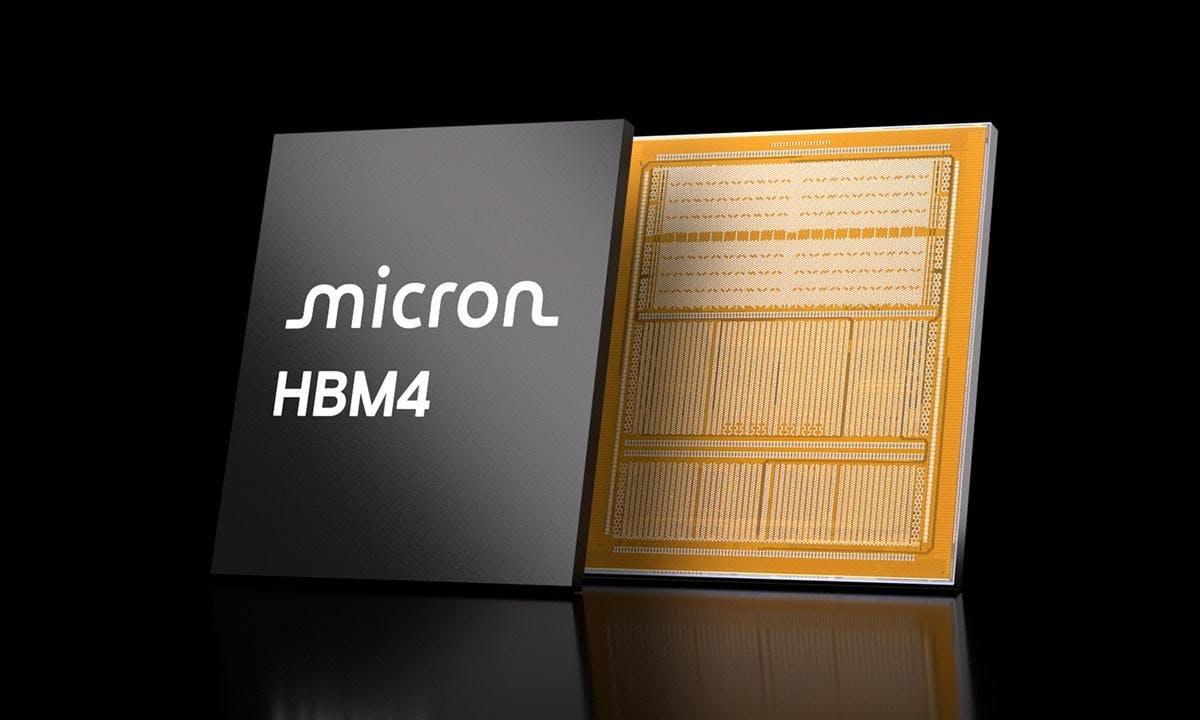

美光36GB HBM4樣品開始出貨給主要客戶,提升60%以上傳輸性能與提高20%能源效率

具備高吞吐量的HBM記憶體是當前HPC與AI運算不可或缺的關鍵元件之一,美光宣布已經針對多家主要客戶提供36GB 12層 HBM4的樣品,藉由更高的頻寬提升通訊與吞吐量,能夠如大型語言模型、推論推理性能進一步提升;美光強調相較HBM3E提升60%以上的頻寬,同時增強20%的能源效率。 美光預計於2026年量產HBM4記憶體,並預告將與客戶下一代AI平台量產同步 ▲美光HBM4基於1-beta製程,每記憶體堆疊頻寬預期超過2TB/s 美光的HBM4記憶體基於成熟的1-beta DRAM製程,並結合12層先進封裝與記憶體自檢測(MBIST)技術提供AI平台客戶與合作夥伴所需的性能及可靠性;美光HB

1 個月前