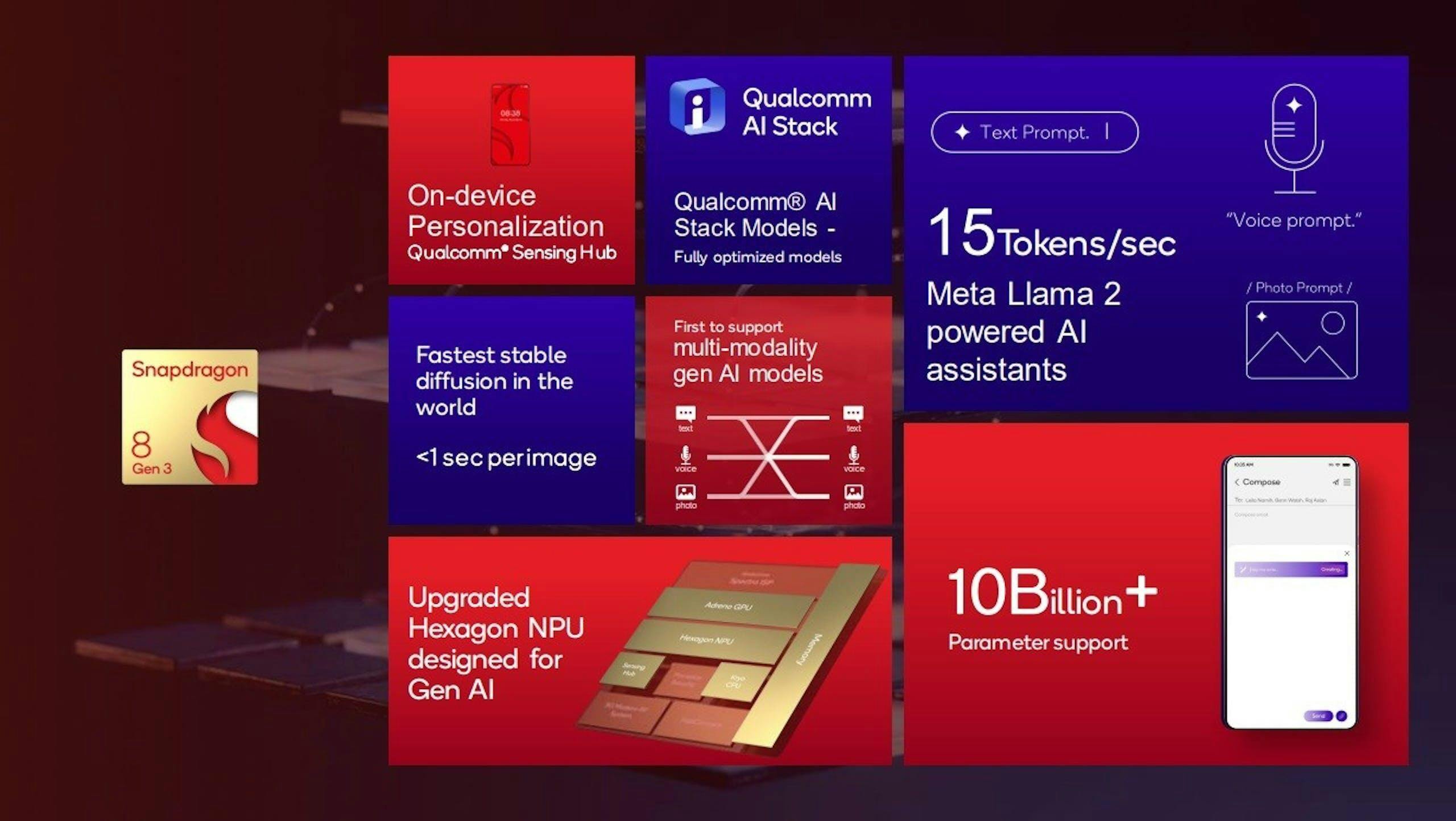

在2023年的高通Snapdragon高峰會,高通介紹Snapdragon 8 Gen 3時,特別聚焦在AI算力與可執行的模型大小,藉此強調是足以在裝置端執行生成式AI的平台,而緊接在後的聯發科天璣9300發表會也不認輸的公布比高通更高的數據;事隔一年,高通新一代旗艦平台Snapdragon 8 Elite雖然同樣聚焦在邊際AI,但卻未刻意公布AI性能與可執行的模型規模,而是著重在溝通能夠以低延遲的方式執行多模態模型(LMM)。

會有這樣的溝通變化並非算力不再重要,而是與手機規格的現狀及生成式AI模型的發展有關。回到現實面,即便2023年高通與聯發科的平台都足以執行超過10B參數的大型語言模型,但最終真正落實在商用設備的語言模型不會超過7B參數,因為最現實的問題就是即便是旗艦級手機,仍可能僅配置8GB的記憶體容量,等同處理器能夠執行更大的模型,但卻沒有足夠的記憶體。

此外,在短短的一年內,2024年生成式AI又有了翻天覆地的改變,更小規模如3B參數的AI模型展現比2023年7B參數更出色的表現,除了演算法的改變,透過更大規模的模型進行精煉,也使得較小規模的模型越來越優秀;不過畢竟在相同世代的模型,參數大小仍會影響精確表現,同時隨著中階平台逐步強化NPU性能藉此支援生成式AI,故現階段3B左右的規模仍會是在智慧手機執行的主流。

然而手機裝置端AI的性能因此不再重要嗎?當然不是,現在進入另一種不同情況的軍備競賽,在考慮到商用裝置的AI模型可能會陷入一定程度的齊頭式平等,各家強調的將會是如何提升結果產出的速度與縮減延遲,故高通Snapdragon 8 Elite也特別強調具備更大、更快的快取以及更快的與記憶體連結的頻寬,因為快取與記憶體的速度對於生成結果的速度至關重要。

至於未來在手機端執行的AI模型參數是否會繼續增加?筆者認為關鍵仍取決在手機業界的裝置記憶體容量低標是否提高,至少可視為成本控制典範的蘋果已經示範了為何使iPhone能夠執行Apple Intelligence,包括iPhone 16標準機型、新款iPad mini的記憶體都分別自前一代的6GB與4GB提升至8GB。