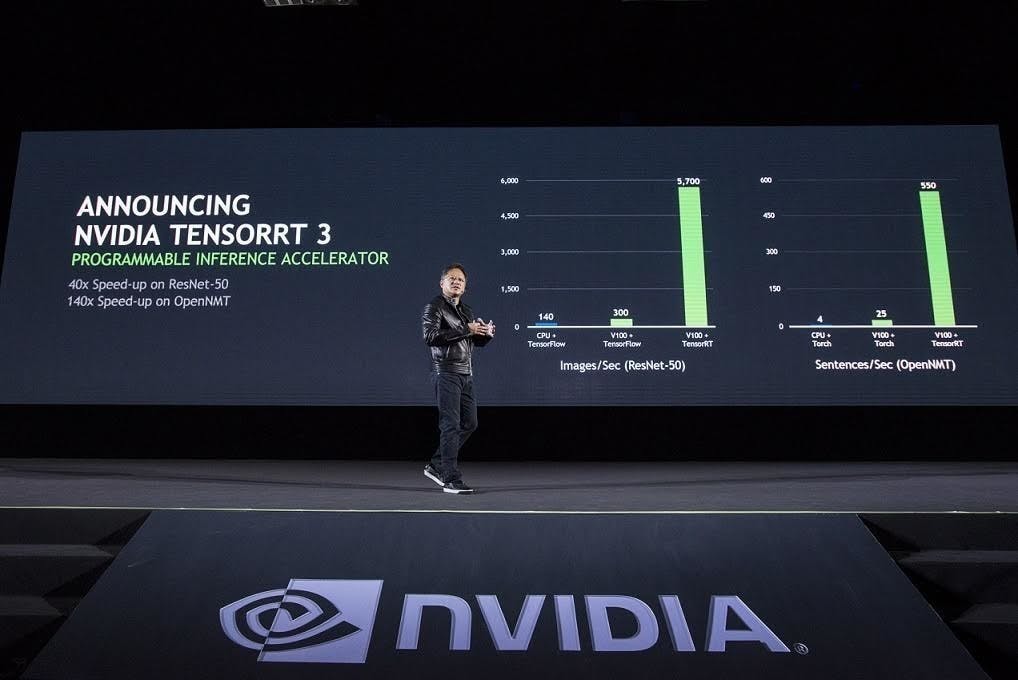

NVIDIA 在中國 GTC 宣布 TensorRT 3 ,加速大型資料中心 AI 推論

NVIDIA 在稍早的中國 GTC大會宣布 TensorRT 3推論軟體,能夠應用在包括影像與語音辨識、自然語言處理、圖像搜尋與個人化建議等各類 AI應用領域,並且標榜 TensorRT搭配 NVIDIA Tesla加速器僅需 CPU 解決方案 1/10 成本,卻能在相同的應用中發揮 40 倍推論效能。 TensorRT 3 主要針對江 AI 部屬到線上產品,為具備最佳化高效能編程器與執行引擎,能夠針對類神經網路進行快速最佳化與驗證後用於於推論,能夠將訓練完的類神經網路導入超大型資料中心以及車用 GPU 平台; TensorRT 具備高精度 INT8 、 FP16 浮點運算能力,相較其他訓練框

7 年前