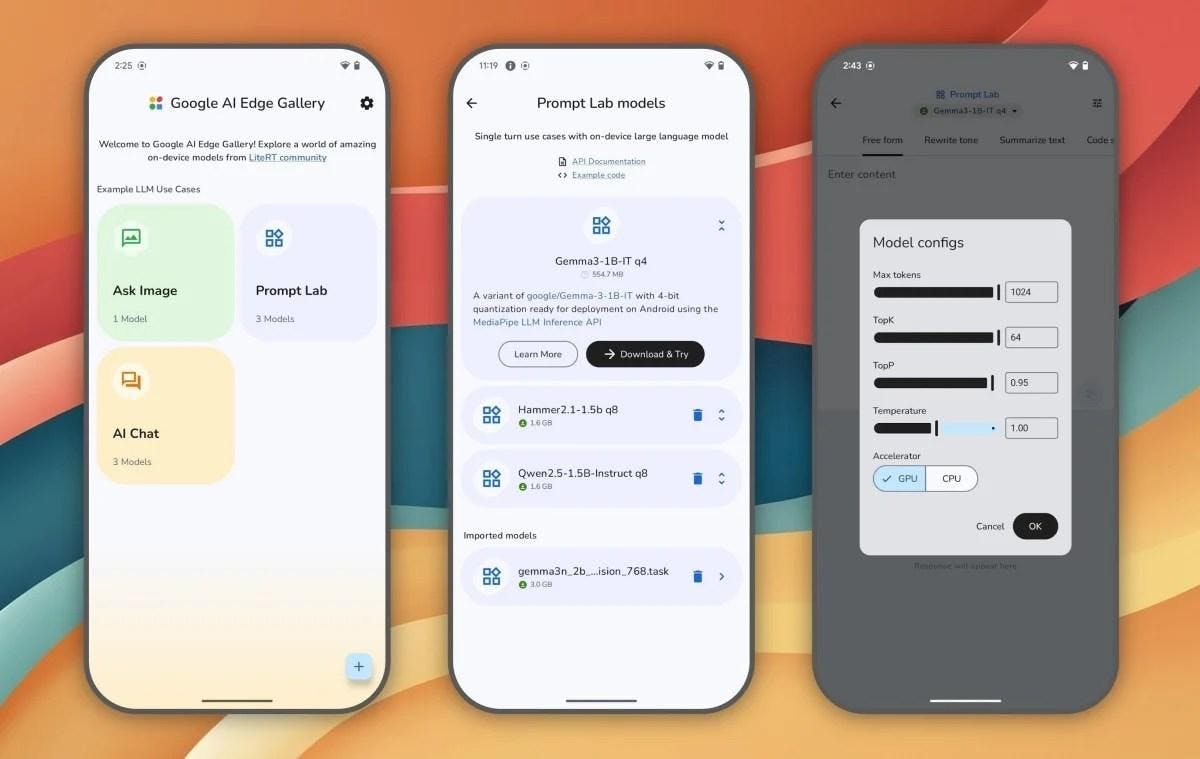

Google AI Edge Gallery 可離線運行於 Android 手機

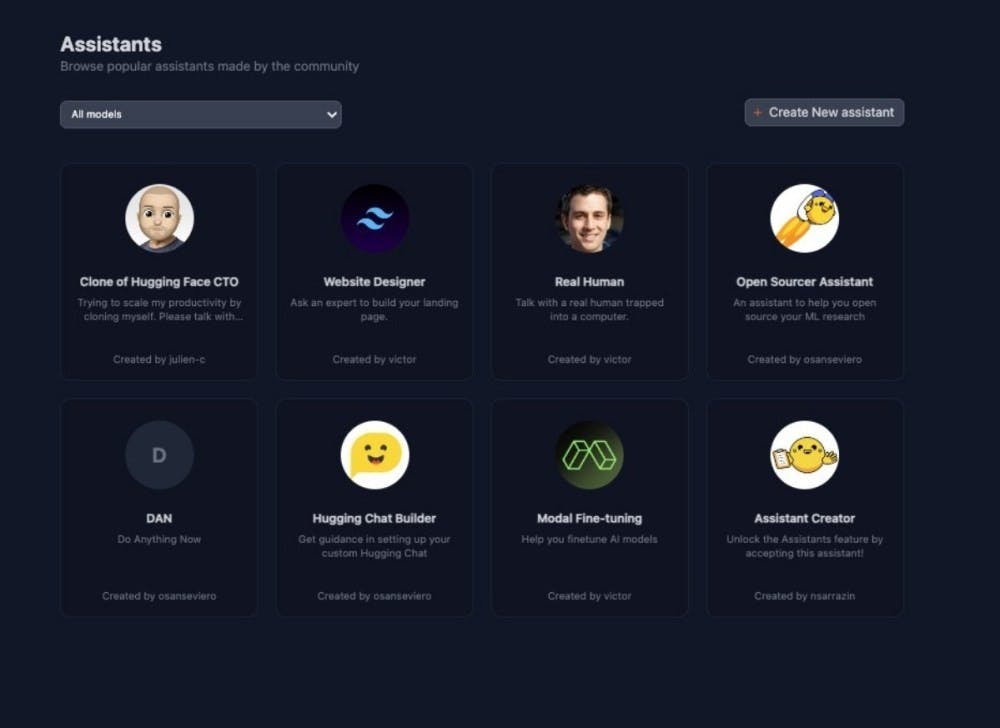

Google 發表 AI Edge Gallery,Android 手機可離線運行 Hugging Face 託管的 AI 模型,支援圖像生成、問答與程式碼撰寫等功能。 Google近期悄悄再GitHub釋出名為Google AI Edge Gallery的App,將讓使用者能在Android手機執行來自Hugging Face服務平台所託管的人工智慧模型,接下來更計畫推出iOS平台版本。 而透過Google AI Edge Gallery運作的人工智慧模型,均可在裝置端離線運作,無須連網使用,避免使用者的個人隱私上傳到雲端,造成有隱私外洩風險。而此App更以Apache 2.0許可方式提供使

1 個月前