SIGGRAPH 2023 : NVIDIA AI Workbench 加速全球企業使用自定義生成式 AI ,簡化模型調整自部署程序

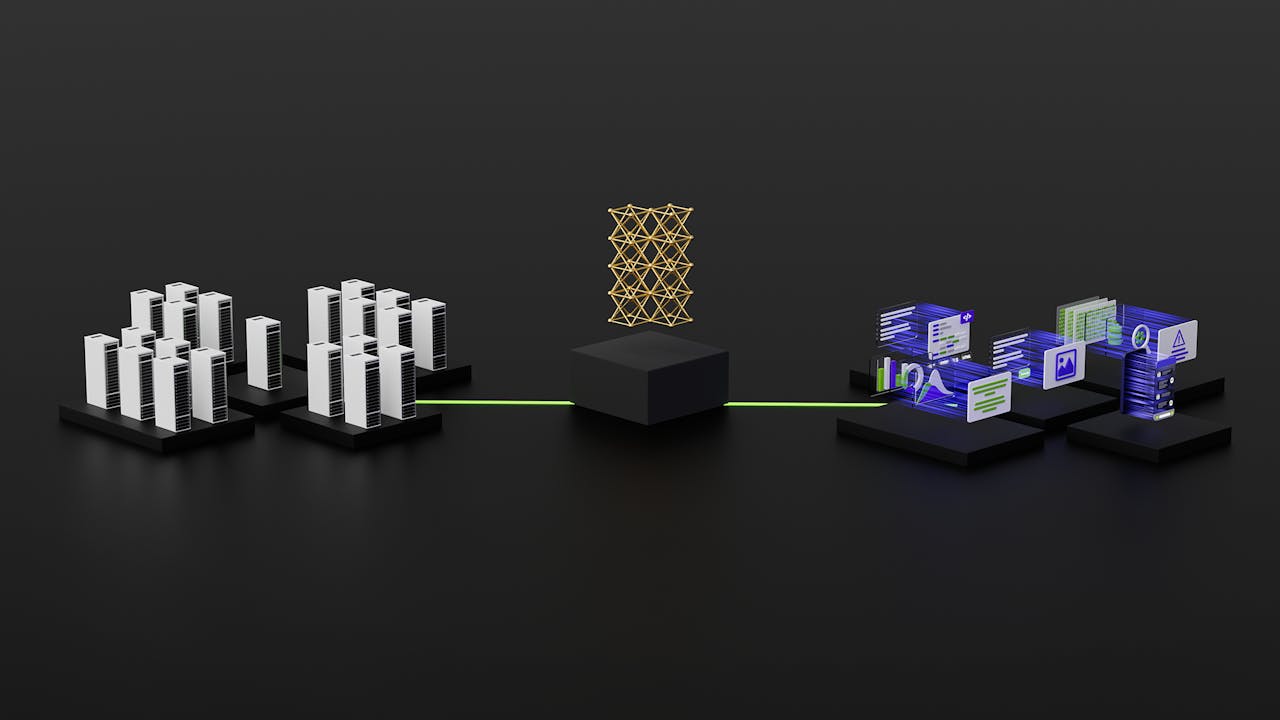

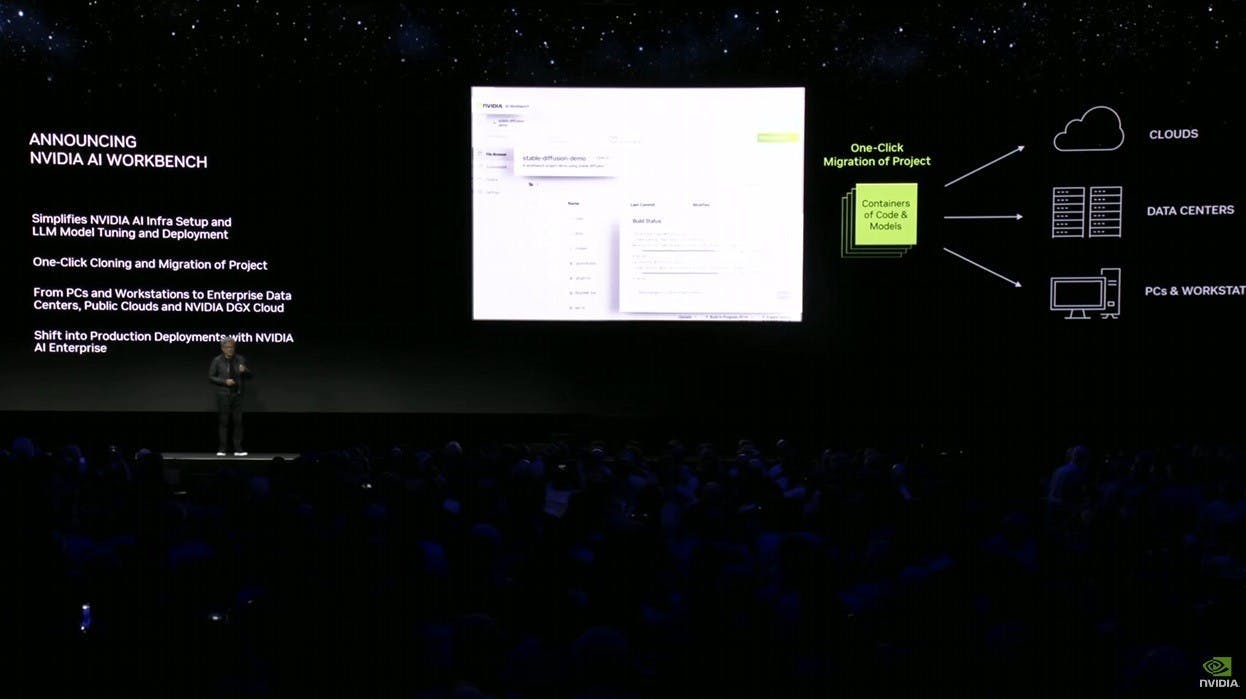

NVIDIA 在 SIGGRAPH 宣布整合易用的工作空間 NVIDIA AI Workbench ,使開發者利用 NVIDIA AI Workbench 在桌上型電腦或工作站環境快速建立、測試與自訂預訓練生成式 AI 大型語言模型,並擴大到資料中心、公有雲或 NVIDIA DGX Cloud ,協助企業加速採用符合需求的自訂生成式 AI 。 NVIDIA AI Workbench 旨在簡化企業使用 AI 項目的各項作業,開發者可在本地系統執行減化界面,就能使用自定義資料自 Hugging Face 、 GitHub 與 NVIDIAS NGC 等熱門資源庫自定義模型,後續於多個平台分享。 現

1 年前