GTC 2024:NVIDIA DGX GB200液冷伺服器動眼看,由18台GB200 Superchip的機架伺服器、9台NVSwitch構成的大型AI Factory單元

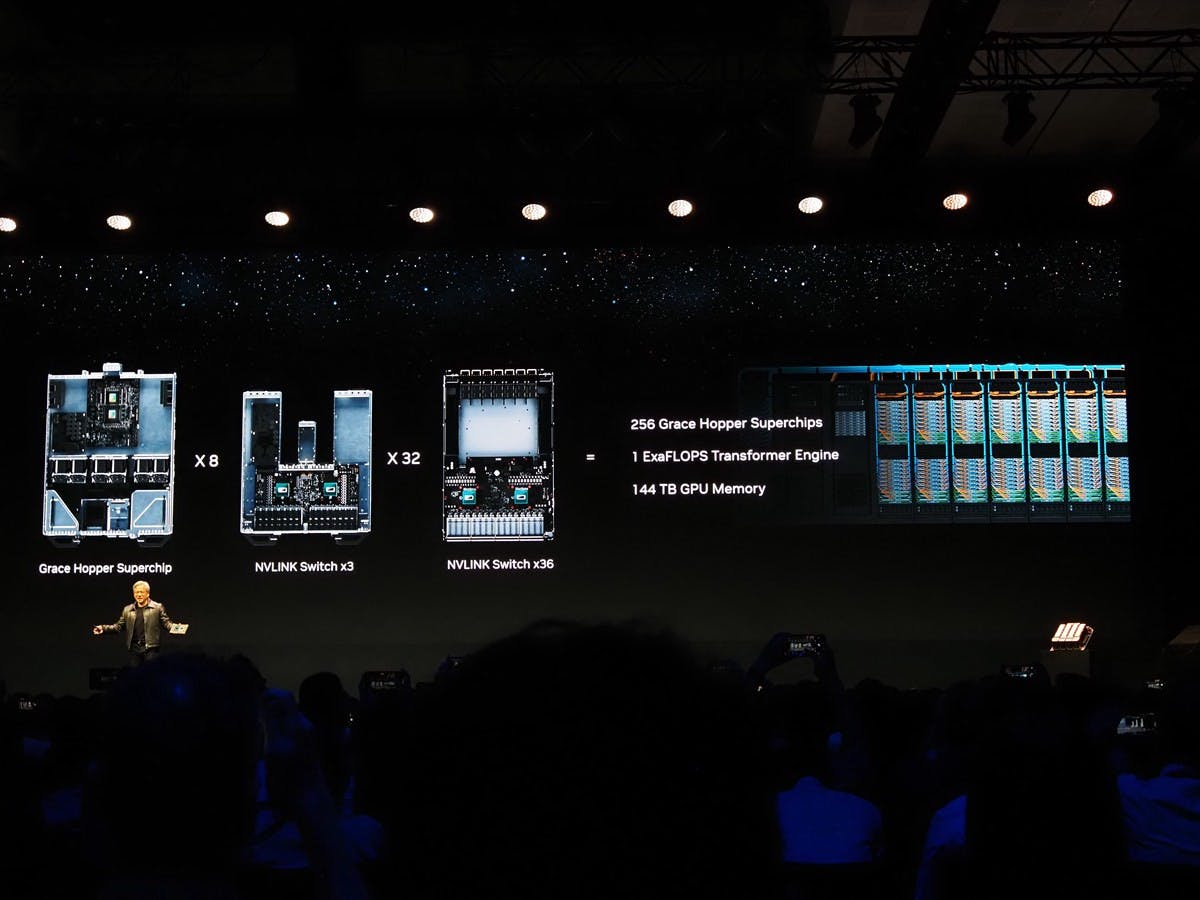

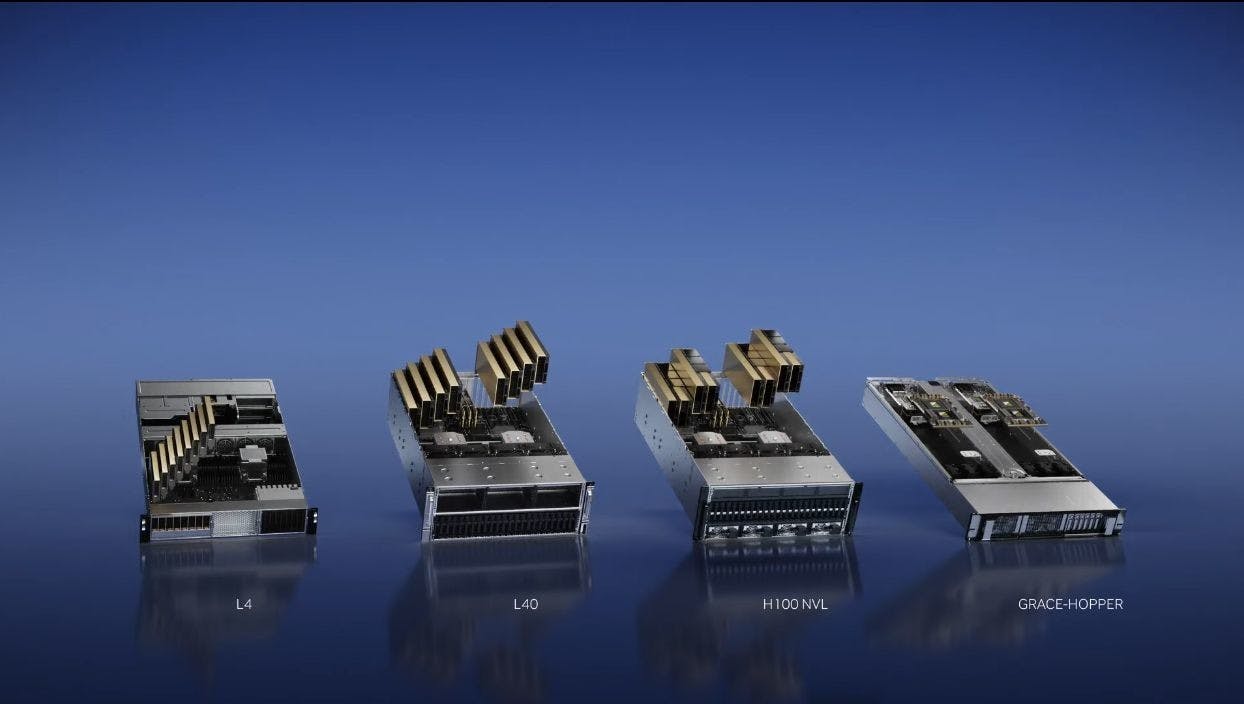

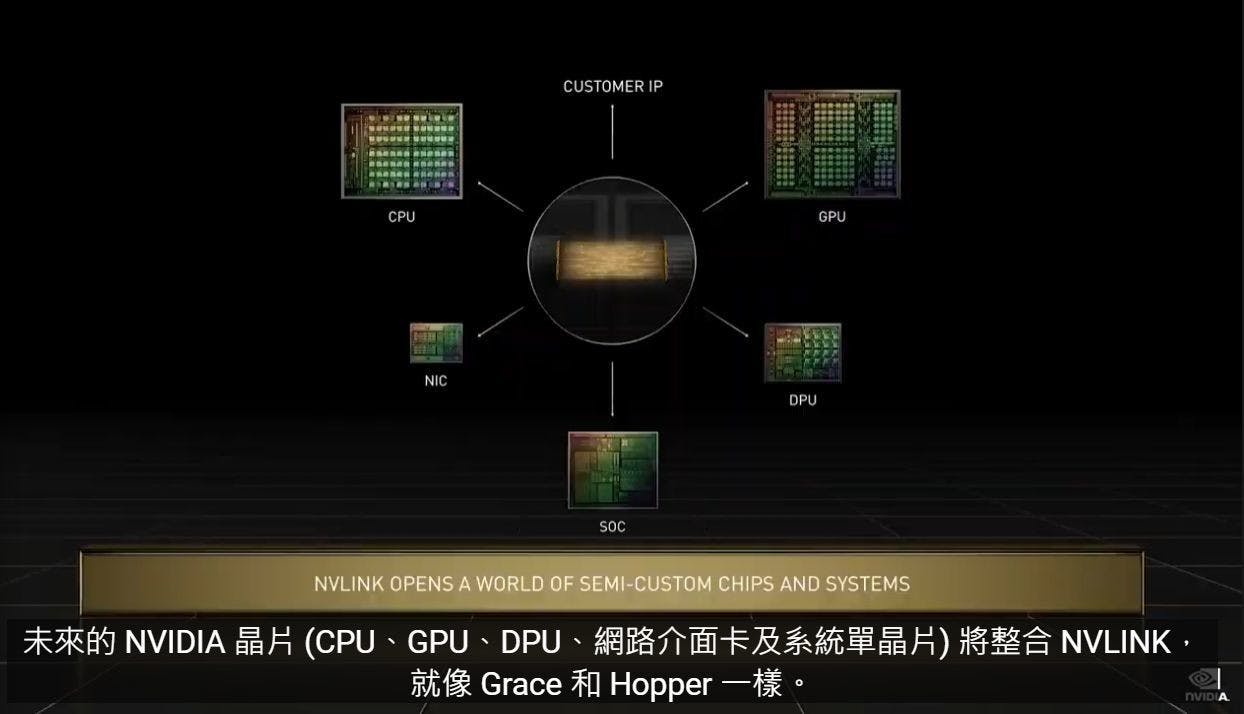

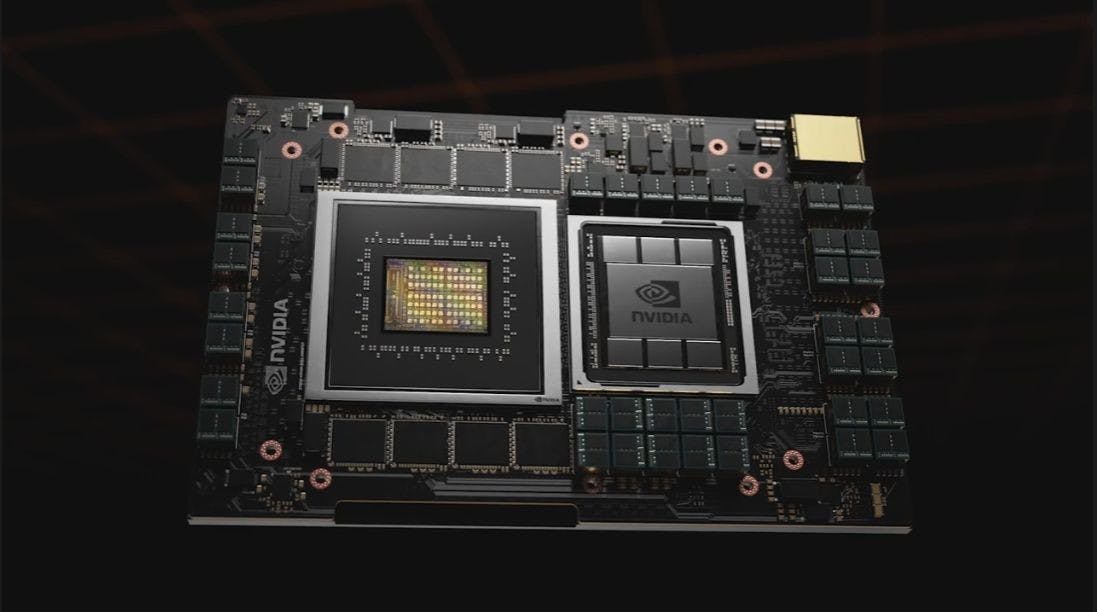

NVIDIA在GTC 2024公布基於NVIDIA GB200 NVL72的DGX GB200系統,在會場也展示實際的設計;不同於過往x86形式的DGX系統是由2個x86晶片以PCIe連接到具備8個NVIDIA GPU的NVLink載板的風冷式機架伺服器,DGX GB200則是由18台載有兩套NVIDIA GB200 Superchip的1U伺服器,搭配9台NVSwitch的NVLink交換器等構成,同時也僅有液冷散熱單一設計。 ▲左側為NVSwitch交換器,中間與右方分別為移除水冷頭的以及覆蓋有液冷頭的GB200 Superchip伺服器 ▲後方白色的纜線為NVSwitch的銅纜 ▲液冷道

1 年前